Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Unabhängige Analyse von KI-Modellen und Hosting-Providern - wählen Sie das beste Modell und den besten API-Anbieter für Ihren Anwendungsfall

DeepSeek hat V3.2 Exp mit ihrer neuen DeepSeek Sparse Attention (DSA) Architektur gestartet, die behauptet, die Auswirkungen der quadratischen Skalierung der Berechnungen mit der Kontextlänge zu reduzieren.

Wir haben V3.2 Exp unabhängig benchmarked und festgestellt, dass es eine ähnliche Intelligenz wie DeepSeek V3.1 Terminus erreicht; DeepSeek hat auf die Verwendung von V3.2 für ihren Haupt-API-Endpunkt umgeschaltet und die API-Preise um mehr als 50 % gesenkt. Mit den aktualisierten Preisen der ersten Partei API von DeepSeek sinken die Kosten für den Betrieb des Artificial Analysis Intelligence Index von 114 $ auf 41 $.

DeepSeek behauptet, die Trainingskonfigurationen von V3.1 Terminus und V3.2 Exp "absichtlich ausgerichtet" zu haben. Die Übereinstimmung mit der Leistung von V3.1 Terminus scheint zu zeigen, dass die Leistungsgewinne der DeepSeek Sparse Attention Architektur nicht auf Kosten der Intelligenz gehen.

Wichtige Benchmark-Ergebnisse:

➤🧠 Keine Veränderung der aggregierten Intelligenz: Im Denkmodus erzielt DeepSeek V3.2 Exp 57 im Artificial Analysis Intelligence Index. Wir sehen dies als gleichwertig in der Intelligenz zu DeepSeek V3.1 Terminus (Denkweise)

➤📈 Kein Rückgang im langen Kontextdenken: Trotz der Architekturänderungen von DeepSeek scheint V3.2 Exp (Denkweise) keinen Rückgang im langen Kontextdenken zu zeigen - es erzielt einen leichten Anstieg im AA-LCR.

➤⚡ Nicht-Denk-Leistung: Im Nicht-Denk-Modus zeigt DeepSeek V3.2 Exp keine Verschlechterung der Intelligenz und erreicht mit 46 im Artificial Analysis Intelligence Index die gleiche Punktzahl wie DeepSeek V3.1 Terminus.

➤⚙️ Token-Effizienz: Für DeepSeek V3.2 Exp (Denkweise) sinkt der Tokenverbrauch zur Ausführung des Artificial Analysis Intelligence Index leicht von 67M auf 62M im Vergleich zu V3.1 Terminus. Der Tokenverbrauch bleibt für die Nicht-Denk-Variante unverändert.

➤💲Preise: DeepSeek hat die Preise pro Token für ihre erste Partei API erheblich von 0,56 $/1,68 $ auf 0,28 $/0,42 $ pro 1M Eingabe/Ausgabe-Token gesenkt - eine Reduzierung der Preise für Eingabe- und Ausgabe-Token um 50 % bzw. 75 %.

Weitere Modelldetails:

➤©️ Lizenzierung: DeepSeek V3.2 Exp ist unter der MIT-Lizenz verfügbar.

➤🌐 Verfügbarkeit: DeepSeek V3.2 Exp ist über die DeepSeek API verfügbar, die DeepSeek V3.1 Terminus ersetzt hat. Benutzer können weiterhin auf DeepSeek V3.1 Terminus über eine temporäre DeepSeek API bis zum 15. Oktober zugreifen.

➤📏 Größe: DeepSeek V3.2 Exp hat insgesamt 671B Parameter und 37B aktive Parameter. Dies ist dasselbe wie bei allen vorherigen Modellen der DeepSeek V3 und R1 Serien.

37,86K

ServiceNow hat Apriel-v1.5-15B-Thinker veröffentlicht, ein 15B Open-Weights-Reasoning-Modell, das unsere Kategorie der kleinen Modelle (<40B Parameter) anführt

💼 Übersicht: Apriel-v1.5-15B-Thinker ist ein dichtes, 15B-Parameter Open-Weights-Reasoning-Modell. Dies ist nicht das erste Modell, das ServiceNow veröffentlicht hat, sondern ein erheblicher Sprung in der Intelligenz im Vergleich zu früheren Veröffentlichungen

🧠 Intelligenz: Das Modell erzielt 52 im Artificial Analysis Intelligence Index. Damit ist es auf Augenhöhe mit DeepSeek R1 0528, das eine viel größere Architektur mit 685B Parametern hat. Das Modell von ServiceNow schneidet besonders gut in wichtigen Verhaltensweisen für Unternehmensagenten ab, wie z.B. der Befolgung von Anweisungen (62 % in IFBench, vor gpt-oss-20B, Reasoning) und Multi-Turn-Konversionen & Werkzeugnutzung (68 % in 𝜏²-Bench Telecom, vor gpt-oss-120B, Reasoning). Dies macht es besonders gut geeignet für agentische Anwendungsfälle, was wahrscheinlich ein Fokus war, da ServiceNow im Bereich der Unternehmensagenten aktiv ist

⚙️ Ausgabetoken und Ausführlichkeit: Das Modell produziert eine große Anzahl von Ausgabetoken, selbst unter den Reasoning-Modellen - es verwendet ~110M kombinierte Reasoning- und Antworttokens, um den Artificial Analysis Intelligence Index abzuschließen

🖥️ Zugriff: Es gibt derzeit keine serverlosen Inferenzanbieter, die das Modell bereitstellen, aber es ist jetzt auf Hugging Face für lokale Inferenz oder Selbstbereitstellung verfügbar. Das Modell wurde unter einer MIT-Lizenz veröffentlicht, die die uneingeschränkte kommerzielle Nutzung unterstützt

ℹ️ Kontextfenster: Das Modell hat ein natives Kontextfenster von 128k Tokens.

Herzlichen Glückwunsch an @ServiceNowRSRCH zu diesem beeindruckenden Ergebnis!

70,93K

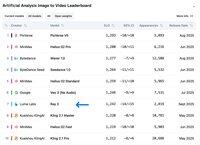

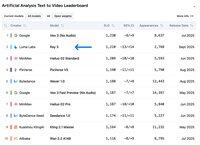

Ray 3 von Luma Labs belegt den 2. Platz im Bereich Text zu Video in der Artificial Analysis Video Arena und liegt nur hinter Googles Veo 3!

@LumaLabsAI hat Ray 3, ein großes Upgrade ihres Ray 2 Modells, veröffentlicht, das den 2. Platz im Bereich Text zu Video und den 7. Platz im Bereich Bild zu Video auf den Ranglisten der Artificial Analysis Video Leaderboards einnimmt.

Mit einem Chain-of-Thought-Ansatz iteriert Ray 3 über die Video-Generierungen und analysiert sie bei jedem Schritt, um Qualität und Einhaltung der Vorgaben sicherzustellen. Das Modell unterstützt sowohl T2V- als auch I2V-Generierungen mit bis zu 10-sekündigen Videos in 1080p Auflösung.

Über die typischen SDR-Generierungen hinaus führt Ray 3 die Unterstützung von 16-Bit HDR ein - das erste seiner Art in der Branche. Dies ermöglicht die HDR-Video-Generierung aus SDR-Bildern und sogar die Umwandlung bestehender SDR-Videos in HDR.

Derzeit ist Ray 3 nur auf der Luma Dream Machine verfügbar, der API-Zugang ist noch nicht verfügbar.

Sehen Sie sich Ray 3 selbst in der Artificial Analysis Video Arena an 🧵

10,77K

Top

Ranking

Favoriten