Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Phân tích độc lập các mô hình AI và nhà cung cấp dịch vụ lưu trữ - chọn mô hình và nhà cung cấp API tốt nhất cho trường hợp sử dụng của bạn

IBM đã ra mắt Granite 4.0 - một gia đình mới của các mô hình ngôn ngữ trọng số mở có kích thước từ 3B đến 32B. Artificial Analysis đã được cung cấp quyền truy cập trước khi phát hành, và các bài kiểm tra của chúng tôi cho thấy Granite 4.0 H Small (32B/9B tổng/số tham số hoạt động) đạt được chỉ số trí tuệ 23, với một điểm mạnh đặc biệt trong hiệu quả token.

Hôm nay, IBM đã phát hành bốn mô hình mới: Granite 4.0 H Small (32B/9B tổng/số tham số hoạt động), Granite 4.0 H Tiny (7B/1B), Granite 4.0 H Micro (3B/3B) và Granite 4.0 Micro (3B/3B). Chúng tôi đã đánh giá Granite 4.0 Small (trong chế độ không lý luận) và Granite 4.0 Micro bằng cách sử dụng chỉ số trí tuệ Artificial Analysis. Các mô hình Granite 4.0 kết hợp một lượng nhỏ các lớp chú ý kiểu transformer tiêu chuẩn với phần lớn các lớp Mamba, mà theo tuyên bố, giảm yêu cầu bộ nhớ mà không ảnh hưởng đến hiệu suất.

Những điểm chính từ bài kiểm tra:

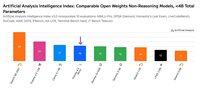

➤🧠 Trí tuệ Granite 4.0 H Small: Trong chế độ không lý luận, Granite 4.0 H Small đạt 23 trên chỉ số trí tuệ Artificial Analysis - một bước nhảy +8 điểm trên chỉ số so với IBM Granite 3.3 8B (Không Lý Luận). Granite 4.0 H Small đứng trước Gemma 3 27B (22) nhưng đứng sau Mistral Small 3.2 (29), EXAONE 4.0 32B (Không Lý Luận, 30) và Qwen3 30B A3B 2507 (Không Lý Luận, 37) về trí tuệ.

➤⚡ Trí tuệ Granite 4.0 Micro: Trên chỉ số trí tuệ Artificial Analysis, Granite 4.0 Micro đạt 16. Nó đứng trước Gemma 3 4B (15) và LFM 2 2.6B (12).

➤⚙️ Hiệu quả token: Granite 4.0 H Small và Micro thể hiện hiệu quả token ấn tượng - Granite 4.0 Small sử dụng 5.2M, trong khi Granite 4.0 Micro sử dụng 6.7M token để chạy chỉ số trí tuệ Artificial Analysis. Cả hai mô hình sử dụng ít token hơn Granite 3.3 8B (Không Lý Luận) và hầu hết các mô hình mở không lý luận khác nhỏ hơn 40B tổng số tham số (trừ Qwen3 0.6B sử dụng 1.9M token đầu ra).

Chi tiết mô hình chính:

➤🌐 Sẵn có: Tất cả bốn mô hình đều có sẵn trên Hugging Face. Granite 4.0 H Small có sẵn trên Replicate và có giá $0.06/$0.25 cho mỗi 1M token đầu vào/đầu ra.

➤📏 Cửa sổ ngữ cảnh: 128K token.

➤©️ Giấy phép: Các mô hình Granite 4.0 có sẵn theo giấy phép Apache 2.0.

27,18K

DeepSeek đã ra mắt V3.2 Exp với kiến trúc DeepSeek Sparse Attention (DSA) mới của họ, tuyên bố rằng nó giảm thiểu tác động của việc mở rộng theo cấp số nhân của tính toán với độ dài ngữ cảnh.

Chúng tôi đã độc lập đánh giá V3.2 Exp đạt được trí thông minh tương tự như DeepSeek V3.1 Terminus; DeepSeek đã chuyển sang sử dụng V3.2 cho điểm cuối API chính của họ và đã giảm giá API hơn 50%. Với giá API của DeepSeek được cập nhật, chi phí để chạy Chỉ số Trí thông minh Phân tích Nhân tạo giảm từ 114 đô la xuống 41 đô la.

DeepSeek tuyên bố đã "cố ý điều chỉnh" các cấu hình đào tạo của V3.1 Terminus và V3.2 Exp. Việc khớp với hiệu suất của V3.1 Terminus dường như chứng minh rằng các lợi ích về hiệu suất của kiến trúc DeepSeek Sparse Attention không đi kèm với chi phí cho trí thông minh.

Những điểm chính từ việc đánh giá:

➤🧠 Không thay đổi về trí thông minh tổng thể: Trong chế độ lý luận, DeepSeek V3.2 Exp đạt 57 trên Chỉ số Trí thông minh Phân tích Nhân tạo. Chúng tôi coi điều này tương đương về trí thông minh với DeepSeek V3.1 Terminus (Lý luận)

➤📈 Không suy giảm trong lý luận ngữ cảnh dài: Mặc dù có sự thay đổi trong kiến trúc của DeepSeek, V3.2 Exp (Lý luận) dường như không có sự suy giảm nào trong lý luận ngữ cảnh dài - đạt được một chút tăng nhẹ trong AA-LCR.

➤⚡ Hiệu suất không lý luận: Trong chế độ không lý luận, DeepSeek V3.2 Exp không cho thấy sự suy giảm về trí thông minh, khớp với DeepSeek V3.1 Terminus với điểm số 46 trên Chỉ số Trí thông minh Phân tích Nhân tạo.

➤⚙️ Hiệu quả token: Đối với DeepSeek V3.2 Exp (Lý luận), việc sử dụng token để chạy Chỉ số Trí thông minh Phân tích Nhân tạo giảm nhẹ từ 67M xuống 62M so với V3.1 Terminus. Việc sử dụng token không thay đổi đối với biến thể không lý luận.

➤💲Giá cả: DeepSeek đã giảm đáng kể giá mỗi token cho API bên thứ nhất của họ từ 0.56 đô la/1.68 đô la xuống 0.28 đô la/0.42 đô la cho 1 triệu token đầu vào/đầu ra - giảm 50% và 75% giá cả của token đầu vào và đầu ra tương ứng.

Các chi tiết khác về mô hình:

➤©️ Giấy phép: DeepSeek V3.2 Exp có sẵn theo Giấy phép MIT.

➤🌐 Sự sẵn có: DeepSeek V3.2 Exp có sẵn qua API DeepSeek, đã thay thế DeepSeek V3.1 Terminus. Người dùng vẫn có thể truy cập DeepSeek V3.1 Terminus qua một API DeepSeek tạm thời cho đến ngày 15 tháng 10.

➤📏 Kích thước: DeepSeek V3.2 Exp có 671B tham số tổng cộng và 37B tham số hoạt động. Đây là cùng kích thước với tất cả các mô hình trước đó trong loạt DeepSeek V3 và R1.

40,91K

ServiceNow đã phát hành Apriel-v1.5-15B-Thinker, một mô hình lý luận với trọng số mở 15B dẫn đầu trong danh mục Mô hình Nhỏ của chúng tôi (<40B tham số)

💼 Tổng quan: Apriel-v1.5-15B-Thinker là một mô hình lý luận với trọng số mở 15B tham số dày đặc. Đây không phải là mô hình đầu tiên mà ServiceNow phát hành nhưng là một bước nhảy vọt đáng kể về trí tuệ đạt được so với các phiên bản trước

🧠 Trí tuệ: Mô hình đạt điểm 52 trong Chỉ số Trí tuệ Phân tích Nhân tạo. Điều này đặt nó ngang hàng với DeepSeek R1 0528, có kiến trúc tham số lớn hơn nhiều là 685B. Mô hình của ServiceNow đạt điểm đặc biệt tốt trong các hành vi quan trọng cho các tác nhân doanh nghiệp, chẳng hạn như tuân theo hướng dẫn (62% trong IFBench, vượt qua gpt-oss-20B, lý luận) và chuyển đổi nhiều lượt & sử dụng công cụ (68% trong 𝜏²-Bench Telecom, vượt qua gpt-oss-120B, lý luận). Điều này khiến nó đặc biệt phù hợp với các trường hợp sử dụng tác nhân, điều này có thể là một trọng tâm vì ServiceNow đang hoạt động trong lĩnh vực tác nhân doanh nghiệp

⚙️ Số lượng token đầu ra và độ dài: Mô hình sản xuất một số lượng lớn token đầu ra ngay cả trong số các mô hình lý luận - sử dụng ~110M token lý luận và trả lời kết hợp để hoàn thành Chỉ số Trí tuệ Phân tích Nhân tạo

🖥️ Truy cập: Chưa có nhà cung cấp suy diễn không máy chủ nào phục vụ mô hình này, nhưng nó hiện có sẵn trên Hugging Face cho suy diễn cục bộ hoặc tự triển khai. Mô hình đã được phát hành dưới giấy phép MIT, hỗ trợ sử dụng thương mại không hạn chế

ℹ️ Cửa sổ ngữ cảnh: Mô hình có cửa sổ ngữ cảnh gốc là 128k token.

Chúc mừng @ServiceNowRSRCH về kết quả ấn tượng này!

73,1K

Hàng đầu

Thứ hạng

Yêu thích