Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Независимый анализ моделей ИИ и хостинг-провайдеров - выберите лучшую модель и поставщика API для вашего сценария использования

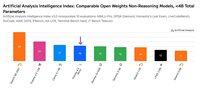

IBM запустила Granite 4.0 - новую семью языковых моделей с открытыми весами размером от 3B до 32B. Artificial Analysis предоставила доступ до релиза, и наши тесты показывают, что Granite 4.0 H Small (32B/9B общих/активных параметров) набирает 23 по Индексу Интеллекта, с особой силой в эффективности токенов.

Сегодня IBM выпустила четыре новые модели: Granite 4.0 H Small (32B/9B общих/активных параметров), Granite 4.0 H Tiny (7B/1B), Granite 4.0 H Micro (3B/3B) и Granite 4.0 Micro (3B/3B). Мы оценили Granite 4.0 Small (в режиме без рассуждений) и Granite 4.0 Micro, используя Индекс Интеллекта Artificial Analysis. Модели Granite 4.0 сочетают небольшое количество стандартных слоев внимания в стиле трансформеров с большинством слоев Mamba, которые, как утверждается, уменьшают требования к памяти без ущерба для производительности.

Ключевые выводы из тестирования:

➤🧠 Интеллект Granite 4.0 H Small: В режиме без рассуждений Granite 4.0 H Small набирает 23 по Индексу Интеллекта Artificial Analysis - это увеличение на +8 пунктов по сравнению с IBM Granite 3.3 8B (без рассуждений). Granite 4.0 H Small опережает Gemma 3 27B (22), но уступает Mistral Small 3.2 (29), EXAONE 4.0 32B (без рассуждений, 30) и Qwen3 30B A3B 2507 (без рассуждений, 37) по интеллекту.

➤⚡ Интеллект Granite 4.0 Micro: По Индексу Интеллекта Artificial Analysis Granite 4.0 Micro набирает 16. Он опережает Gemma 3 4B (15) и LFM 2 2.6B (12).

➤⚙️ Эффективность токенов: Granite 4.0 H Small и Micro демонстрируют впечатляющую эффективность токенов - Granite 4.0 Small использует 5.2M, в то время как Granite 4.0 Micro использует 6.7M токенов для работы с Индексом Интеллекта Artificial Analysis. Оба модели используют меньше токенов, чем Granite 3.3 8B (без рассуждений) и большинство других моделей с открытыми весами без рассуждений, меньших 40B общих параметров (за исключением Qwen3 0.6B, который использует 1.9M выходных токенов).

Ключевые детали модели:

➤🌐 Доступность: Все четыре модели доступны на Hugging Face. Granite 4.0 H Small доступна на Replicate и стоит $0.06/$0.25 за 1M входных/выходных токенов.

➤📏 Контекстное окно: 128K токенов.

➤©️ Лицензирование: Модели Granite 4.0 доступны под лицензией Apache 2.0.

34,3K

DeepSeek запустил V3.2 Exp с новой архитектурой DeepSeek Sparse Attention (DSA), которая, как утверждается, снижает влияние квадратичного увеличения вычислений с длиной контекста.

Мы независимо протестировали V3.2 Exp и установили, что он достигает аналогичного уровня интеллекта, как DeepSeek V3.1 Terminus; DeepSeek перешел на использование V3.2 для своего основного API и снизил цены на API более чем на 50%. С обновленными ценами на первый API от DeepSeek стоимость запуска Индекса Искусственного Анализа Интеллекта снижается с 114 долларов до 41 доллара.

DeepSeek утверждает, что "умышленно согласовал" конфигурации обучения V3.1 Terminus и V3.2 Exp. Соответствие производительности V3.1 Terminus, похоже, демонстрирует, что преимущества производительности архитектуры DeepSeek Sparse Attention не идут в ущерб интеллекту.

Ключевые выводы из бенчмаркинга:

➤🧠 Нет изменений в совокупном интеллекте: В режиме рассуждения DeepSeek V3.2 Exp набирает 57 баллов в Индексе Искусственного Анализа Интеллекта. Мы считаем это эквивалентом интеллекта DeepSeek V3.1 Terminus (Рассуждение).

➤📈 Нет снижения в долгосрочном контексте рассуждений: Несмотря на изменения в архитектуре DeepSeek, V3.2 Exp (Рассуждение) не демонстрирует снижения в долгосрочном контексте рассуждений - набирая небольшое увеличение в AA-LCR.

➤⚡ Производительность вне рассуждений: В режиме вне рассуждений DeepSeek V3.2 Exp не показывает ухудшения интеллекта, соответствуя DeepSeek V3.1 Terminus с результатом 46 в Индексе Искусственного Анализа Интеллекта.

➤⚙️ Эффективность токенов: Для DeepSeek V3.2 Exp (Рассуждение) использование токенов для запуска Индекса Искусственного Анализа Интеллекта немного снижается с 67M до 62M по сравнению с V3.1 Terminus. Использование токенов остается неизменным для варианта вне рассуждений.

➤💲Цены: DeepSeek значительно снизил цену за токен для своего первого API с 0.56$/1.68$ до 0.28$/0.42$ за 1M входных/выходных токенов - снижение цен на 50% и 75% соответственно для входных и выходных токенов.

Другие детали модели:

➤©️ Лицензирование: DeepSeek V3.2 Exp доступен под лицензией MIT.

➤🌐 Доступность: DeepSeek V3.2 Exp доступен через API DeepSeek, который заменил DeepSeek V3.1 Terminus. Пользователи все еще могут получить доступ к DeepSeek V3.1 Terminus через временный API DeepSeek до 15 октября.

➤📏 Размер: DeepSeek V3.2 Exp имеет 671B общих параметров и 37B активных параметров. Это то же самое, что и у всех предыдущих моделей в сериях DeepSeek V3 и R1.

41,14K

ServiceNow выпустила Apriel-v1.5-15B-Thinker, модель рассуждений с открытыми весами на 15B, которая возглавляет нашу категорию Малых Моделей (<40B параметров)

💼 Обзор: Apriel-v1.5-15B-Thinker — это плотная модель рассуждений с открытыми весами на 15B параметров. Это не первая модель, выпущенная ServiceNow, но это значительный скачок в интеллекте по сравнению с предыдущими выпусками

🧠 Интеллект: Модель набирает 52 в Индексе Искусственного Анализа Интеллекта. Это ставит её наравне с DeepSeek R1 0528, которая имеет гораздо более крупную архитектуру на 685B параметров. Модель ServiceNow особенно хорошо справляется с важными поведениями для корпоративных агентов, такими как следование инструкциям (62% в IFBench, впереди gpt-oss-20B, рассуждение) и многопользовательские преобразования и использование инструментов (68% в 𝜏²-Bench Telecom, впереди gpt-oss-120B, рассуждение). Это делает её особенно подходящей для агентских случаев использования, что, вероятно, было в центре внимания, учитывая, что ServiceNow активно работает в области корпоративных агентов

⚙️ Выходные токены и многословие: Модель производит большое количество выходных токенов даже среди моделей рассуждений - используя ~110M комбинированных токенов рассуждений и ответов для завершения Индекса Искусственного Анализа Интеллекта

🖥️ Доступ: На данный момент нет серверных провайдеров без серверной инференции, которые обслуживают модель, но она уже доступна на Hugging Face для локальной инференции или самостоятельного развертывания. Модель была выпущена под лицензией MIT, поддерживающей неограниченное коммерческое использование

ℹ️ Контекстное окно: Модель имеет родное контекстное окно на 128k токенов.

Поздравляем @ServiceNowRSRCH с этим впечатляющим результатом!

74,34K

Топ

Рейтинг

Избранное