Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Незалежний аналіз моделей штучного інтелекту та хостинг-провайдерів - виберіть найкращу модель та API провайдера для вашого випадку використання

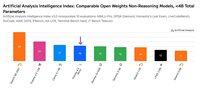

IBM випустила Granite 4.0 - нове сімейство моделей відкритої ваги розміром від 3B до 32B. Штучний аналіз був наданий перед релізом, і наш порівняльний аналіз показує, що Granite 4.0 H Small (32B/9B загальні/активні параметри) отримав індекс інтелекту 23, з особливою перевагою в ефективності токенів

Сьогодні IBM випустила чотири нові моделі: Granite 4.0 H Small (загальні/активні параметри 32B/9B), Granite 4.0 H Tiny (7B/1B), Granite 4.0 H Micro (3B/3B) та Granite 4.0 Micro (3B/3B). Ми оцінили Granite 4.0 Small (у режимі без міркувань) та Granite 4.0 Micro за допомогою Artificial Analysis Intelligence Index. Моделі Granite 4.0 поєднують в собі невелику кількість стандартних шарів уваги в стилі трансформера з більшістю шарів Mamba, що стверджується, зменшує вимоги до пам'яті без шкоди для продуктивності

Ключові висновки бенчмаркінгу:

🧠 ➤ Granite 4.0 H Small Intelligence: У неміркуваннях Granite 4.0 H Small отримує 23 бали за індексом Artificial Analysis Intelligence - стрибок на +8 балів за індексом у порівнянні з IBM Granite 3.3 8B (Non Reasoning). Граніт 4.0 H Малі місця випереджають Gemma 3 27B (22), але відстають Mistral Small 3.2 (29), EXAONE 4.0 32B (Non-Reasoning, 30) і Qwen3 30B A3B 2507 (Non-Reasoning, 37) за інтелектом

⚡ ➤ Граніт 4.0 Мікроінтелект: за індексом інтелекту штучного аналізу, Granite 4.0 Micro оцінюється в 16 балів. Він випереджає Gemma 3 4B (15) та LFM 2 2.6B (12).

⚙️ ➤ Ефективність токенів: Granite 4.0 H Small і Micro демонструють вражаючу ефективність токенів - Granite 4.0 Small використовує 5.2M, тоді як Granite 4.0 Micro використовує 6.7M токенів для запуску Artificial Analysis Intelligence Index. Обидві моделі мають менше токенів, ніж Granite 3.3, 8B (Non-Reasoning) і більшість інших моделей з відкритими вагами, що не мають розуму, менше 40B, загальні параметри (крім Qwen3 0.6B, який використовує 1,9M вихідних токенів)

Ключові деталі моделі:

🌐 ➤ Наявність: Усі чотири моделі доступні на Hugging Face. Granite 4.0 H Small доступний на Replicate і коштує $0,06/$0,25 за 1M вхідних/вихідних токенів

📏 ➤ Контекстне вікно: 128 тисяч токенів

©️ ➤ Ліцензування: моделі Granite 4.0 доступні за ліцензією Apache 2.0

30,47K

Компанія DeepSeek запустила V3.2 Exp зі своєю новою архітектурою DeepSeek Sparse Attention (DSA), яка стверджує, що зменшує вплив квадратичного масштабування обчислень на довжину контексту

Ми незалежно порівняли V3.2 Exp як таку, що має подібний інтелект до DeepSeek V3.1 Terminus; DeepSeek перейшли на використання V3.2 для своєї основної кінцевої точки API та знизили ціну на API на >50%. Завдяки оновленим цінам на API першої сторони DeepSeek вартість запуску індексу інтелекту штучного аналізу впала зі 114 доларів США до 41 долара.

DeepSeek стверджує, що «навмисно вирівняв» тренувальні конфігурації V3.1 Terminus і V3.2 Exp. Відповідність продуктивності V3.1 Terminus, схоже, демонструє, що переваги продуктивності архітектури DeepSeek Spare Attention не коштують інтелекту.

Ключові висновки бенчмаркінгу:

🧠 ➤ Відсутність змін у сукупному інтелекті: у режимі міркувань DeepSeek V3.2 Exp отримує 57 балів за індексом інтелекту штучного аналізу. Ми розглядаємо це як еквівалент за інтелектом DeepSeek V3.1 Terminus (Reasoning)

📈 ➤ Відсутність зниження в міркуваннях з довгим контекстом: Незважаючи на зміни в архітектурі DeepSeek, V3.2 Exp (Reasoning), схоже, не демонструє жодного зниження в міркуваннях з довгим контекстом - це невелике зростання в AA-LCR.

⚡ ➤ Продуктивність без міркувань: У режимі без міркувань DeepSeek V3.2 Exp не демонструє погіршення інтелекту, відповідаючи DeepSeek V3.1 Terminus з оцінкою 46 балів за індексом інтелекту штучного аналізу

⚙️ ➤ Ефективність токена: Для DeepSeek V3.2 Exp (Reasoning) використання токена для запуску Artificial Analysis Intelligence Index дещо знижується з 67 Млн до 62 млн порівняно з V3.1 Terminus. Використання токенів залишається незмінним для варіанту без обґрунтування

➤💲Ціноутворення: DeepSeek значно знизив ціну за токен для свого основного API з $0,56/$1,68 до $0,28/$0,42 за 1M токенів введення/виведення - зниження на 50% і 75% у ціні вхідних та вихідних токенів відповідно.

Інші деталі моделі:

©️ ➤ Ліцензування: DeepSeek V3.2 Exp доступний за ліцензією MIT

🌐 ➤ Доступність: DeepSeek V3.2 Exp доступний через DeepSeek API, який замінив DeepSeek V3.1 Terminus. Користувачі все ще можуть отримати доступ до DeepSeek V3.1 Terminus через тимчасовий API DeepSeek до 15 жовтня

📏 ➤ Розмір: DeepSeek V3.2 Exp має 671B загальних параметрів і 37B активних параметрів. Це так само, як і у всіх попередніх моделей серій DeepSeek V3 і R1

40,92K

ServiceNow випустила Apriel-v1.5-15B-Thinker, модель міркувань з відкритими вагами 15B, яка лідирує в нашій категорії малих моделей (параметри <40B)

💼 Огляд: Apriel-v1.5-15B-Thinker - це щільна модель міркувань з відкритими вагами 15B параметрів. Це не перша модель, яку випустила ServiceNow, але це значний стрибок у інтелекті, досягнутий у порівнянні з минулими релізами

🧠 Інтелект: модель набрала 52 бали в Індексі інтелекту штучного аналізу. Це ставить його в один ряд з DeepSeek R1 0528, який має набагато більшу архітектуру параметрів 685B. Модель ServiceNow особливо добре показує себе в рамках важливих моделей поведінки для корпоративних агентів, таких як слідування інструкцій (62% в IFBench, випереджаючи gpt-oss-20B, міркування) і багатоходові перетворення та використання інструментів (68% в τ²-Bench Telecom, випереджаючи gpt-oss-120B, міркування). Це робить його особливо придатним для випадків використання агентів, що, ймовірно, було в центрі уваги, враховуючи, що ServiceNow активний у сфері корпоративних агентів

⚙️ Вихідні токени та детальність: Модель виробляє велику кількість вихідних токенів навіть серед моделей міркувань - використовуючи ~110 мільйонів комбінованих токенів міркувань і відповідей для завершення індексу інтелекту штучного аналізу

🖥️ Доступ: Жодні постачальники безсерверних висновків ще не обслуговують модель, але вона вже доступна на Hugging Face для локального висновування або самостійного розгортання. Модель була випущена за ліцензією Массачусетського технологічного інституту, що підтримує необмежене комерційне використання

i️ Контекстне вікно: модель має власне контекстне вікно зі 128 тисячами токенів.

Вітаємо @ServiceNowRSRCH з цим вражаючим результатом!

73,9K

Найкращі

Рейтинг

Вибране