Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Analisi indipendente dei modelli di intelligenza artificiale e dei provider di hosting: scegli il modello e il fornitore API migliori per il tuo caso d'uso

DeepSeek ha lanciato V3.2 Exp con la loro nuova architettura DeepSeek Sparse Attention (DSA) che afferma di ridurre l'impatto della scalabilità quadratica del calcolo con la lunghezza del contesto

Abbiamo valutato in modo indipendente V3.2 Exp come raggiungente un'intelligenza simile a DeepSeek V3.1 Terminus; DeepSeek ha iniziato a utilizzare V3.2 per il loro endpoint API principale e ha ridotto i prezzi API di oltre il 50%. Con i prezzi aggiornati dell'API di prima parte di DeepSeek, il costo per eseguire l'Artificial Analysis Intelligence Index scende da $114 a $41.

DeepSeek afferma di aver "allineato deliberatamente" le configurazioni di addestramento di V3.1 Terminus e V3.2 Exp. Abbinare le prestazioni di V3.1 Terminus sembra dimostrare che i benefici delle prestazioni dell'architettura DeepSeek Spare Attention non comportano un costo per l'intelligenza.

Punti chiave dei benchmark:

➤🧠 Nessun cambiamento nell'intelligenza aggregata: In modalità ragionamento, DeepSeek V3.2 Exp ottiene 57 sull'Artificial Analysis Intelligence Index. Vediamo questo come equivalente in intelligenza a DeepSeek V3.1 Terminus (Ragionamento)

➤📈 Nessun calo nel ragionamento a lungo termine: Nonostante i cambiamenti architettonici di DeepSeek, V3.2 Exp (Ragionamento) sembra non mostrare alcun calo nel ragionamento a lungo termine - ottenendo un leggero aumento in AA-LCR.

➤⚡ Prestazioni non di ragionamento: In modalità non di ragionamento, DeepSeek V3.2 Exp non mostra degradazione nell'intelligenza, abbinando DeepSeek V3.1 Terminus con un punteggio di 46 sull'Artificial Analysis Intelligence Index

➤⚙️ Efficienza dei token: Per DeepSeek V3.2 Exp (Ragionamento), l'uso dei token per eseguire l'Artificial Analysis Intelligence Index diminuisce leggermente da 67M a 62M rispetto a V3.1 Terminus. L'uso dei token rimane invariato per la variante non di ragionamento

➤💲Prezzi: DeepSeek ha ridotto significativamente il prezzo per token per la loro API di prima parte da $0.56/$1.68 a $0.28/$0.42 per 1M di token di input/output - una riduzione del 50% e del 75% nei prezzi dei token di input e output rispettivamente.

Altri dettagli del modello:

➤©️ Licenza: DeepSeek V3.2 Exp è disponibile sotto la Licenza MIT

➤🌐 Disponibilità: DeepSeek V3.2 Exp è disponibile tramite l'API DeepSeek, che ha sostituito DeepSeek V3.1 Terminus. Gli utenti possono ancora accedere a DeepSeek V3.1 Terminus tramite un'API DeepSeek temporanea fino al 15 ottobre

➤📏 Dimensione: DeepSeek V3.2 Exp ha 671B di parametri totali e 37B di parametri attivi. Questo è lo stesso di tutti i modelli precedenti nella serie DeepSeek V3 e R1.

37,82K

ServiceNow ha rilasciato Apriel-v1.5-15B-Thinker, un modello di ragionamento con pesi aperti da 15B che guida la nostra categoria di Modelli Piccoli (<40B parametri)

💼 Panoramica: Apriel-v1.5-15B-Thinker è un modello di ragionamento denso con 15B di parametri e pesi aperti. Questo non è il primo modello rilasciato da ServiceNow, ma rappresenta un notevole salto in intelligenza rispetto ai rilasci passati.

🧠 Intelligenza: Il modello ottiene un punteggio di 52 nell'Artificial Analysis Intelligence Index. Questo lo pone alla pari con DeepSeek R1 0528, che ha un'architettura di parametri molto più grande, 685B. Il modello di ServiceNow ottiene punteggi particolarmente buoni in comportamenti importanti per gli agenti aziendali, come il seguire istruzioni (62% in IFBench, davanti a gpt-oss-20B, ragionamento) e conversazioni multi-turno e utilizzo di strumenti (68% in 𝜏²-Bench Telecom, davanti a gpt-oss-120B, ragionamento). Questo lo rende particolarmente adatto a casi d'uso agentici, il che è probabilmente stato un obiettivo dato che ServiceNow è attiva nel settore degli agenti aziendali.

⚙️ Token di output e verbosità: Il modello produce un gran numero di token di output anche tra i modelli di ragionamento - utilizzando ~110M di token di ragionamento e risposta combinati per completare l'Artificial Analysis Intelligence Index.

🖥️ Accesso: Nessun fornitore di inferenza serverless sta ancora servendo il modello, ma è disponibile ora su Hugging Face per inferenza locale o auto-deploy. Il modello è stato rilasciato sotto una licenza MIT, supportando l'uso commerciale illimitato.

ℹ️ Finestra di contesto: Il modello ha una finestra di contesto nativa di 128k token.

Congratulazioni a @ServiceNowRSRCH per questo risultato impressionante!

62,06K

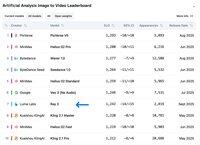

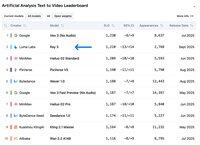

Ray 3 di Luma Labs si classifica al #2 nella categoria Testo in Video nell'Arena dei Video di Analisi Artificiale, superato solo da Veo 3 di Google!

@LumaLabsAI ha lanciato Ray 3, un importante aggiornamento del loro modello Ray 2, che si posiziona al #2 nel Testo in Video e al #7 nell'Immagine in Video nelle classifiche dei Video di Analisi Artificiale.

Utilizzando un approccio a catena di pensiero, Ray 3 itera sulle generazioni video, analizzandole ad ogni passaggio per garantire qualità e aderenza alle richieste. Il modello supporta sia generazioni T2V che I2V con video fino a 10 secondi in risoluzione 1080p.

Oltre alle generazioni SDR tipiche, Ray 3 introduce il supporto HDR a 16 bit - il primo nel settore. Questo consente la generazione di video HDR da immagini SDR e persino la conversione di video SDR esistenti in HDR.

Attualmente, Ray 3 è disponibile solo su Luma Dream Machine, con accesso API non ancora disponibile.

Guarda Ray 3 di persona nell'Arena dei Video di Analisi Artificiale 🧵

10,77K

Principali

Ranking

Preferiti