Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Uavhengig analyse av AI-modeller og vertsleverandører - velg den beste modellen og API-leverandøren for ditt bruksområde

DeepSeek har lansert V3.2 Exp med deres nye DeepSeek Sparse Attention (DSA)-arkitektur som hevder å redusere virkningen av kvadratisk skalering av databehandling med kontekstlengde

Vi har uavhengig benchmarket V3.2 Exp for å oppnå lignende intelligens som DeepSeek V3.1 Terminus; DeepSeek har gått over til å bruke V3.2 for deres viktigste API-endepunkt og har redusert API-prisene med >50 %. Med DeepSeeks oppdaterte førsteparts API-priser, faller kostnadene for å kjøre Artificial Analysis Intelligence Index fra $114 til $41.

DeepSeek hevder å ha "bevisst justert" treningskonfigurasjonene til V3.1 Terminus og V3.2 Exp. Matching V3.1 Terminus' ytelse ser ut til å demonstrere at ytelsesfordelene til DeepSeek Spare Attention-arkitekturen ikke kommer på bekostning av intelligens.

Viktige benchmarking-takeaways:

➤ 🧠 Ingen endring i aggregert intelligens: I resonnementmodus scorer DeepSeek V3.2 Exp 57 på Artificial Analysis Intelligence Index. Vi ser dette som ekvivalent i intelligens med DeepSeek V3.1 Terminus (resonnement)

➤ 📈 Ingen nedgang i resonnement med lang kontekst: Til tross for DeepSeeks arkitekturendringer, ser det ut til at V3.2 Exp (Reasoning) ikke viser noen nedgang i resonnement i lang kontekst - noe som gir en liten økning i AA-LCR.

➤ ⚡ Ikke-resonnerende ytelse: I ikke-resonnerende modus viser DeepSeek V3.2 Exp ingen forringelse i intelligens, og matcher DeepSeek V3.1 Terminus med en poengsum på 46 på Artificial Analysis Intelligence Index

➤ ⚙️ Tokeneffektivitet: For DeepSeek V3.2 Exp (resonnement) reduseres tokenbruken for å kjøre Artificial Analysis Intelligence Index litt fra 67M til 62M sammenlignet med V3.1 Terminus. Tokenbruk forblir uendret for den ikke-resonnerende varianten

➤💲Priser: DeepSeek har betydelig redusert prisen per token for deres førsteparts API fra $0,56/$1,68 til $0,28/$0,42 per 1M input/output-tokens – en reduksjon på 50 % og 75 % i prisingen av henholdsvis input- og output-tokens.

Andre modelldetaljer:

➤ ©️ Lisensiering: DeepSeek V3.2 Exp er tilgjengelig under MIT-lisensen

➤ 🌐 Tilgjengelighet: DeepSeek V3.2 Exp er tilgjengelig via DeepSeek API, som har erstattet DeepSeek V3.1 Terminus. Brukere kan fortsatt få tilgang til DeepSeek V3.1 Terminus via en midlertidig DeepSeek API frem til 15

➤ 📏 Størrelse: DeepSeek V3.2 Exp har 671B totale parametere og 37B aktive parametere. Dette er det samme som alle tidligere modeller i DeepSeek V3- og R1-serien

35,1K

ServiceNow har gitt ut Apriel-v1.5-15B-Thinker, en 15B resonneringsmodell med åpne vekter som leder vår kategori for små modeller (<40B-parametere)

💼 Oversikt: Apriel-v1.5-15B-Thinker er en tett, 15B parameter åpen vekter resonneringsmodell. Dette er ikke den første modellen ServiceNow har gitt ut, men er et betydelig hopp i intelligens oppnådd sammenlignet med tidligere utgivelser

🧠 Intelligens: Modellen scorer 52 i Artificial Analysis Intelligence Index. Dette setter den på nivå med DeepSeek R1 0528, som har en mye større 685B parameterarkitektur. ServiceNows modell skårer spesielt godt innenfor viktig atferd for bedriftsagenter, for eksempel instruksjonsfølging (62 % i IFBench, foran gpt-oss-20B, resonnement) og multi-turn-konverteringer og verktøybruk (68 % i τ²-Bench Telecom, foran gpt-oss-120B, resonnement). Dette gjør den spesielt godt egnet for agentiske brukstilfeller, noe som sannsynligvis var et fokus gitt at ServiceNow er aktiv i bedriftsagentområdet

⚙️ Utdatatokens og detaljnivå: Modellen produserer et stort antall utdatatokener selv blant resonneringsmodeller – ved å bruke ~110 millioner kombinerte resonnement- og svartokener for å fullføre indeksen for kunstig analyseintelligens

🖥️ Tilgang: Ingen serverløse slutningsleverandører betjener modellen ennå, men den er tilgjengelig nå på Hugging Face for lokal slutning eller selvdistribusjon. Modellen er utgitt under en MIT-lisens, som støtter ubegrenset kommersiell bruk

i️ Kontekstvindu: Modellen har et opprinnelig kontekstvindu på 128k tokener.

Gratulerer til @ServiceNowRSRCH med dette imponerende resultatet!

61,8K

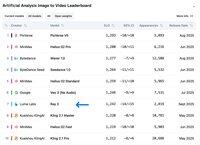

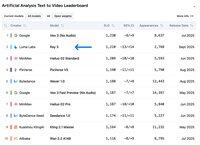

Luma Labs' Ray 3 rangerer #2 i tekst til video i videoarenaen for kunstig analyse, bare bak Googles Veo 3!

@LumaLabsAI har lansert Ray 3, en stor oppgradering av deres Ray 2-modell, som kommer inn på #2 i tekst til video og #7 i bilde til video på Artificial Analysis Video Leaderboards.

Ved å bruke en tankekjedetilnærming itererer Ray 3 videogenerasjoner, og analyserer dem på hvert trinn for å sikre kvalitet og rask etterlevelse. Modellen støtter både T2V- og I2V-generasjoner med opptil 10-sekunders videoer med 1080p-oppløsning.

Utover typiske SDR-generasjoner, introduserer Ray 3 16-bits HDR-støtte - den første i bransjen. Dette tillater HDR-videogenerering fra SDR-bilder og til og med konvertering av eksisterende SDR-videoer til HDR.

Foreløpig er Ray 3 kun tilgjengelig på Luma Dream Machine, med API-tilgang som ennå ikke er tilgjengelig.

Se Ray 3 selv i videoarenaen 🧵 for kunstig analyse

10,51K

Topp

Rangering

Favoritter