Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Análisis independiente de modelos de IA y proveedores de alojamiento: elija el mejor modelo y proveedor de API para su caso de uso

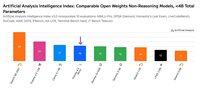

IBM ha lanzado Granite 4.0 - una nueva familia de modelos de lenguaje de pesos abiertos que varían en tamaño desde 3B hasta 32B. Artificial Analysis tuvo acceso anticipado a la versión, y nuestras pruebas muestran que Granite 4.0 H Small (32B/9B parámetros totales/activos) obtiene un Índice de Inteligencia de 23, con una fortaleza particular en la eficiencia de tokens.

Hoy IBM lanzó cuatro nuevos modelos: Granite 4.0 H Small (32B/9B parámetros totales/activos), Granite 4.0 H Tiny (7B/1B), Granite 4.0 H Micro (3B/3B) y Granite 4.0 Micro (3B/3B). Evaluamos Granite 4.0 Small (en modo no razonamiento) y Granite 4.0 Micro utilizando el Índice de Inteligencia de Artificial Analysis. Los modelos Granite 4.0 combinan una pequeña cantidad de capas de atención estilo transformer estándar con la mayoría de las capas Mamba, que afirman reducir los requisitos de memoria sin afectar el rendimiento.

Puntos clave de las pruebas:

➤🧠 Inteligencia de Granite 4.0 H Small: En modo no razonamiento, Granite 4.0 H Small obtiene 23 en el índice de inteligencia de Artificial Analysis - un aumento de +8 puntos en el índice en comparación con IBM Granite 3.3 8B (No Razonamiento). Granite 4.0 H Small se sitúa por delante de Gemma 3 27B (22) pero detrás de Mistral Small 3.2 (29), EXAONE 4.0 32B (No Razonamiento, 30) y Qwen3 30B A3B 2507 (No Razonamiento, 37) en inteligencia.

➤⚡ Inteligencia de Granite 4.0 Micro: En el Índice de Inteligencia de Artificial Analysis, Granite 4.0 Micro obtiene 16. Se sitúa por delante de Gemma 3 4B (15) y LFM 2 2.6B (12).

➤⚙️ Eficiencia de tokens: Granite 4.0 H Small y Micro demuestran una impresionante eficiencia de tokens - Granite 4.0 Small utiliza 5.2M, mientras que Granite 4.0 Micro utiliza 6.7M tokens para ejecutar el Índice de Inteligencia de Artificial Analysis. Ambos modelos utilizan menos tokens que Granite 3.3 8B (No Razonamiento) y la mayoría de los otros modelos de pesos abiertos no razonamiento más pequeños que 40B parámetros totales (excepto Qwen3 0.6B que utiliza 1.9M tokens de salida).

Detalles clave del modelo:

➤🌐 Disponibilidad: Los cuatro modelos están disponibles en Hugging Face. Granite 4.0 H Small está disponible en Replicate y tiene un precio de $0.06/$0.25 por 1M de tokens de entrada/salida.

➤📏 Ventana de contexto: 128K tokens.

➤©️ Licencia: Los modelos Granite 4.0 están disponibles bajo la licencia Apache 2.0.

32,64K

DeepSeek ha lanzado V3.2 Exp con su nueva arquitectura DeepSeek Sparse Attention (DSA) que afirma reducir el impacto de la escalabilidad cuadrática del cálculo con la longitud del contexto.

Hemos evaluado de forma independiente V3.2 Exp y hemos logrado una inteligencia similar a DeepSeek V3.1 Terminus; DeepSeek ha cambiado a usar V3.2 para su punto final de API principal y ha reducido los precios de la API en más del 50%. Con la actualización de precios de la API de primera parte de DeepSeek, el costo para ejecutar el Índice de Inteligencia de Análisis Artificial cae de $114 a $41.

DeepSeek afirma haber "alineado deliberadamente" las configuraciones de entrenamiento de V3.1 Terminus y V3.2 Exp. Igualar el rendimiento de V3.1 Terminus parece demostrar que los beneficios de rendimiento de la arquitectura DeepSeek Spare Attention no vienen a costa de la inteligencia.

Principales conclusiones de la evaluación:

➤🧠 Sin cambio en la inteligencia agregada: En modo de razonamiento, DeepSeek V3.2 Exp obtiene 57 en el Índice de Inteligencia de Análisis Artificial. Vemos esto como equivalente en inteligencia a DeepSeek V3.1 Terminus (Razonamiento).

➤📈 Sin declive en el razonamiento de contexto largo: A pesar de los cambios en la arquitectura de DeepSeek, V3.2 Exp (Razonamiento) parece no exhibir ningún declive en el razonamiento de contexto largo, obteniendo un ligero aumento en AA-LCR.

➤⚡ Rendimiento no razonado: En modo no razonado, DeepSeek V3.2 Exp no muestra degradación en la inteligencia, igualando a DeepSeek V3.1 Terminus con una puntuación de 46 en el Índice de Inteligencia de Análisis Artificial.

➤⚙️ Eficiencia de tokens: Para DeepSeek V3.2 Exp (Razonamiento), el uso de tokens para ejecutar el Índice de Inteligencia de Análisis Artificial disminuye ligeramente de 67M a 62M en comparación con V3.1 Terminus. El uso de tokens permanece sin cambios para la variante no razonada.

➤💲Precios: DeepSeek ha reducido significativamente el precio por token para su API de primera parte de $0.56/$1.68 a $0.28/$0.42 por 1M de tokens de entrada/salida, una reducción del 50% y 75% en los precios de los tokens de entrada y salida respectivamente.

Otros detalles del modelo:

➤©️ Licencia: DeepSeek V3.2 Exp está disponible bajo la Licencia MIT.

➤🌐 Disponibilidad: DeepSeek V3.2 Exp está disponible a través de la API de DeepSeek, que ha reemplazado a DeepSeek V3.1 Terminus. Los usuarios aún pueden acceder a DeepSeek V3.1 Terminus a través de una API temporal de DeepSeek hasta el 15 de octubre.

➤📏 Tamaño: DeepSeek V3.2 Exp tiene 671B de parámetros totales y 37B de parámetros activos. Esto es lo mismo que todos los modelos anteriores en las series DeepSeek V3 y R1.

41,14K

ServiceNow ha lanzado Apriel-v1.5-15B-Thinker, un modelo de razonamiento de pesos abiertos de 15B que lidera nuestra categoría de Modelos Pequeños (<40B parámetros)

💼 Descripción general: Apriel-v1.5-15B-Thinker es un modelo de razonamiento denso de 15B parámetros con pesos abiertos. Este no es el primer modelo que ha lanzado ServiceNow, pero representa un salto sustancial en inteligencia logrado en comparación con lanzamientos anteriores.

🧠 Inteligencia: El modelo obtiene una puntuación de 52 en el Índice de Inteligencia de Análisis Artificial. Esto lo coloca a la par con DeepSeek R1 0528, que tiene una arquitectura de parámetros mucho más grande de 685B. El modelo de ServiceNow destaca particularmente en comportamientos importantes para agentes empresariales, como el seguimiento de instrucciones (62% en IFBench, por delante de gpt-oss-20B, razonamiento) y conversiones de múltiples turnos y uso de herramientas (68% en 𝜏²-Bench Telecom, por delante de gpt-oss-120B, razonamiento). Esto lo hace particularmente adecuado para casos de uso agéntico, lo cual probablemente fue un enfoque dado que ServiceNow está activo en el espacio de agentes empresariales.

⚙️ Tokens de salida y verbosidad: El modelo produce un gran número de tokens de salida incluso entre los modelos de razonamiento, utilizando ~110M de tokens de razonamiento y respuesta combinados para completar el Índice de Inteligencia de Análisis Artificial.

🖥️ Acceso: Aún no hay proveedores de inferencia sin servidor que estén sirviendo el modelo, pero ya está disponible en Hugging Face para inferencia local o auto-despliegue. El modelo ha sido lanzado bajo una licencia MIT, que apoya el uso comercial sin restricciones.

ℹ️ Ventana de contexto: El modelo tiene una ventana de contexto nativa de 128k tokens.

¡Felicidades a @ServiceNowRSRCH por este impresionante resultado!

74,32K

Parte superior

Clasificación

Favoritos