Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Onafhankelijke analyse van AI-modellen en hostingproviders - kies het beste model en de beste API-provider voor uw use-case

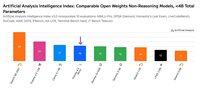

IBM heeft Granite 4.0 gelanceerd - een nieuwe familie van open gewichten taalmodellen variërend in grootte van 3B tot 32B. Artificial Analysis kreeg vooraf toegang, en onze benchmarking toont aan dat Granite 4.0 H Small (32B/9B totale/actieve parameters) een Intelligence Index van 23 behaalt, met een bijzondere sterkte in token efficiëntie.

Vandaag heeft IBM vier nieuwe modellen uitgebracht: Granite 4.0 H Small (32B/9B totale/actieve parameters), Granite 4.0 H Tiny (7B/1B), Granite 4.0 H Micro (3B/3B) en Granite 4.0 Micro (3B/3B). We hebben Granite 4.0 Small (in niet-redeneringsmodus) en Granite 4.0 Micro geëvalueerd met behulp van de Artificial Analysis Intelligence Index. Granite 4.0 modellen combineren een klein aantal standaard transformer-stijl aandachtlagen met een meerderheid van Mamba-lagen die beweert de geheugeneisen te verminderen zonder de prestaties te beïnvloeden.

Belangrijkste benchmarking conclusies:

➤🧠 Granite 4.0 H Small Intelligence: In niet-redenering, scoort Granite 4.0 H Small 23 op de Artificial Analysis Intelligence index - een sprongetje van +8 punten op de Index vergeleken met IBM Granite 3.3 8B (Niet Redenering). Granite 4.0 H Small plaatst zich voor Gemma 3 27B (22) maar achter Mistral Small 3.2 (29), EXAONE 4.0 32B (Niet-Redenering, 30) en Qwen3 30B A3B 2507 (Niet-Redenering, 37) in intelligentie.

➤⚡ Granite 4.0 Micro Intelligence: Op de Artificial Analysis Intelligence Index scoort Granite 4.0 Micro 16. Het plaatst zich voor Gemma 3 4B (15) en LFM 2 2.6B (12).

➤⚙️ Token efficiëntie: Granite 4.0 H Small en Micro tonen indrukwekkende token efficiëntie - Granite 4.0 Small gebruikt 5.2M, terwijl Granite 4.0 Micro 6.7M tokens gebruikt om de Artificial Analysis Intelligence Index te draaien. Beide modellen gebruiken minder tokens dan Granite 3.3 8B (Niet-Redenering) en de meeste andere open gewichten niet-redeneringsmodellen kleiner dan 40B totale parameters (behalve Qwen3 0.6B dat 1.9M output tokens gebruikt).

Belangrijke modelgegevens:

➤🌐 Beschikbaarheid: Alle vier modellen zijn beschikbaar op Hugging Face. Granite 4.0 H Small is beschikbaar op Replicate en is geprijsd op $0.06/$0.25 per 1M input/output tokens.

➤📏 Contextvenster: 128K tokens.

➤©️ Licentie: De Granite 4.0 modellen zijn beschikbaar onder de Apache 2.0 licentie.

35,79K

DeepSeek heeft V3.2 Exp gelanceerd met hun nieuwe DeepSeek Sparse Attention (DSA) architectuur die beweert de impact van de kwadratische schaling van rekenkracht met contextlengte te verminderen.

We hebben V3.2 Exp onafhankelijk getest en vastgesteld dat het vergelijkbare intelligentie bereikt als DeepSeek V3.1 Terminus; DeepSeek is overgestapt op het gebruik van V3.2 voor hun belangrijkste API-eindpunt en heeft de API-prijzen met meer dan 50% verlaagd. Met de bijgewerkte eerste partij API-prijzen van DeepSeek valt de kosten om de Artificial Analysis Intelligence Index uit te voeren van $114 naar $41.

DeepSeek beweert de trainingsconfiguraties van V3.1 Terminus en V3.2 Exp "opzettelijk op elkaar afgestemd" te hebben. Het evenaren van de prestaties van V3.1 Terminus lijkt aan te tonen dat de prestatievoordelen van de DeepSeek Sparse Attention architectuur niet ten koste gaan van de intelligentie.

Belangrijke benchmarkresultaten:

➤🧠 Geen verandering in totale intelligentie: In redeneermodus scoort DeepSeek V3.2 Exp 57 op de Artificial Analysis Intelligence Index. We beschouwen dit als gelijkwaardig in intelligentie aan DeepSeek V3.1 Terminus (Redeneren)

➤📈 Geen afname in lange contextredenering: Ondanks de architectuurveranderingen van DeepSeek lijkt V3.2 Exp (Redeneren) geen afname in lange contextredenering te vertonen - met een lichte stijging in AA-LCR.

➤⚡ Niet-redeneringsprestaties: In niet-redeneringsmodus toont DeepSeek V3.2 Exp geen degradatie in intelligentie, en evenaart DeepSeek V3.1 Terminus met een score van 46 op de Artificial Analysis Intelligence Index.

➤⚙️ Token efficiëntie: Voor DeepSeek V3.2 Exp (Redeneren) daalt het tokenverbruik om de Artificial Analysis Intelligence Index uit te voeren licht van 67M naar 62M vergeleken met V3.1 Terminus. Het tokenverbruik blijft onveranderd voor de niet-redeneringsvariant.

➤💲Prijzen: DeepSeek heeft de prijs per token voor hun eerste partij API aanzienlijk verlaagd van $0.56/$1.68 naar $0.28/$0.42 per 1M invoer/uitvoer tokens - een verlaging van 50% en 75% in de prijzen van invoer- en uitvoertokens respectievelijk.

Andere modelgegevens:

➤©️ Licentie: DeepSeek V3.2 Exp is beschikbaar onder de MIT-licentie.

➤🌐 Beschikbaarheid: DeepSeek V3.2 Exp is beschikbaar via de DeepSeek API, die DeepSeek V3.1 Terminus heeft vervangen. Gebruikers kunnen nog steeds toegang krijgen tot DeepSeek V3.1 Terminus via een tijdelijke DeepSeek API tot 15 oktober.

➤📏 Grootte: DeepSeek V3.2 Exp heeft 671B totale parameters en 37B actieve parameters. Dit is hetzelfde als alle eerdere modellen in de DeepSeek V3 en R1 serie.

41,36K

ServiceNow heeft Apriel-v1.5-15B-Thinker uitgebracht, een 15B open gewichten redeneer model dat onze Small Models-categorie (<40B parameters) leidt.

💼 Overzicht: Apriel-v1.5-15B-Thinker is een dicht, 15B parameter open gewichten redeneer model. Dit is niet het eerste model dat ServiceNow heeft uitgebracht, maar het is een aanzienlijke sprong in intelligentie vergeleken met eerdere releases.

🧠 Intelligentie: Het model scoort 52 in de Artificial Analysis Intelligence Index. Dit plaatst het op gelijke hoogte met DeepSeek R1 0528, dat een veel grotere 685B parameterarchitectuur heeft. Het model van ServiceNow scoort bijzonder goed binnen belangrijke gedragingen voor enterprise agents, zoals instructie opvolging (62% in IFBench, voor gpt-oss-20B, redeneervaardigheid) en multi-turn conversaties & toolgebruik (68% in 𝜏²-Bench Telecom, voor gpt-oss-120B, redeneervaardigheid). Dit maakt het bijzonder geschikt voor agentische gebruiksscenario's, wat waarschijnlijk een focus was gezien ServiceNow actief is in de enterprise agents ruimte.

⚙️ Output tokens en verbosity: Het model produceert een groot aantal output tokens, zelfs onder redeneer modellen - met ~110M gecombineerde redeneer en antwoord tokens om de Artificial Analysis Intelligence Index te voltooien.

🖥️ Toegang: Er zijn nog geen serverless inference providers die het model aanbieden, maar het is nu beschikbaar op Hugging Face voor lokale inferentie of zelf-implementatie. Het model is uitgebracht onder een MIT-licentie, die onbeperkt commercieel gebruik ondersteunt.

ℹ️ Contextvenster: Het model heeft een native contextvenster van 128k tokens.

Gefeliciteerd aan @ServiceNowRSRCH met dit indrukwekkende resultaat!

74,47K

Boven

Positie

Favorieten