热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

约翰·舒尔曼与思维机器:无悔的LoRA

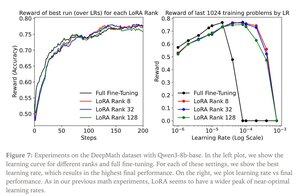

LoRA用修改后的版本W’=W+γBA替换原始模型中的每个权重矩阵W,其中B和A是参数总数远少于W的矩阵。

当以下情况发生时,LoRA的表现与完全微调相似:

1. LoRA应用于网络的所有层,特别是包含大多数参数的MLP/MoE层。

2. LoRA没有容量限制,即可训练参数的数量超过要学习的信息量,这可以通过数据集大小来估算。

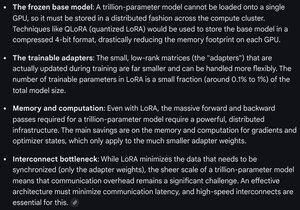

影响:大型(例如万亿参数)基础模型可以以训练新模型的极小成本进行定制。

思考机器的帖子:

Gemini 关于前沿模型上 LoRA 的计算需求 - 仍然相当庞大,但使用的参数数量不到总模型大小的 1%(预训练)。

4.29K

热门

排行

收藏