Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Джон Шульман и Thinking Machines: LoRA без сожалений

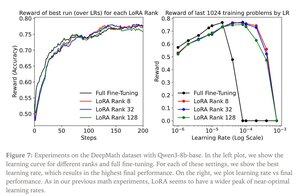

LoRA заменяет каждую матрицу весов W из оригинальной модели на модифицированную версию W’=W+γBAW’=W+γBA, где B и A — это матрицы, которые вместе имеют значительно меньше параметров, чем W.

LoRA работает аналогично полному тонкому обучению, когда:

1. LoRA применяется ко всем слоям сети, особенно к слоям MLP/MoE, в которых сосредоточено большинство параметров.

2. LoRA не ограничена по мощности, т.е. количество обучаемых параметров превышает объем информации, которую нужно усвоить, что можно оценить по размеру набора данных.

Последствия: Большие (например, триллион параметров) базовые модели могут быть настроены за небольшую долю стоимости обучения новой модели.

Пост Thinking Machines:

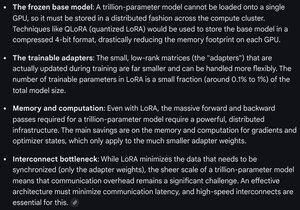

Gemini о вычислительных требованиях для LoRA на модели frontier - все еще значительные, но количество используемых параметров составляет менее 1% от общего размера модели (предобучение).

3,8K

Топ

Рейтинг

Избранное