Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman & Thinking Machines: LoRA Tanpa Penyesalan

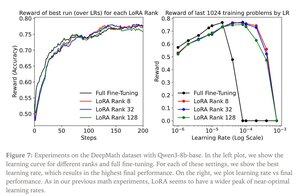

LoRA menggantikan setiap matriks bobot W dari model asli dengan versi modifikasi W'=W+γBAW'=W+γBA, di mana B dan A adalah matriks yang bersama-sama memiliki parameter yang jauh lebih sedikit daripada W.

LoRA melakukan penyempurnaan penuh yang mirip ketika:

1. LoRA diterapkan ke semua lapisan jaringan, terutama lapisan MLP / MoE yang menampung sebagian besar parameter.

2. LoRA tidak dibatasi kapasitas, yaitu, jumlah parameter yang dapat dilatih melebihi jumlah informasi yang akan dipelajari, yang dapat diperkirakan dalam hal ukuran kumpulan data.

Implikasi: Model dasar besar (misalnya triliun parameter) dapat disesuaikan dengan biaya yang lebih murah dari biaya pelatihan model baru.

Postingan Thinking Machines:

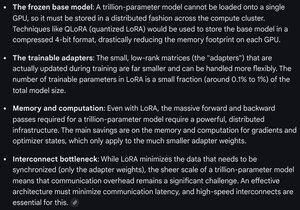

Gemini pada persyaratan komputasi untuk LoRA pada model perbatasan - masih tangguh, tetapi jumlah parameter yang digunakan kurang dari 1% dari total ukuran model (prapelatihan).

9,4K

Teratas

Peringkat

Favorit