Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman & Thinking Machines: LoRA Không Hối Tiếc

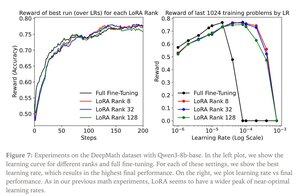

LoRA thay thế mỗi ma trận trọng số W từ mô hình gốc bằng một phiên bản đã được sửa đổi W’=W+γBAW’=W+γBA, trong đó B và A là các ma trận mà tổng số tham số của chúng ít hơn nhiều so với W.

LoRA hoạt động tương tự như việc tinh chỉnh hoàn toàn khi:

1. LoRA được áp dụng cho tất cả các lớp của mạng, đặc biệt là các lớp MLP/MoE nơi chứa hầu hết các tham số.

2. LoRA không bị hạn chế về khả năng, tức là số lượng tham số có thể huấn luyện vượt quá lượng thông tin cần học, điều này có thể được ước lượng dựa trên kích thước tập dữ liệu.

Ý nghĩa: Các mô hình cơ sở lớn (ví dụ như mô hình có một triệu tham số) có thể được tùy chỉnh với chi phí chỉ bằng một phần nhỏ so với việc huấn luyện một mô hình mới.

Bài đăng của Thinking Machines:

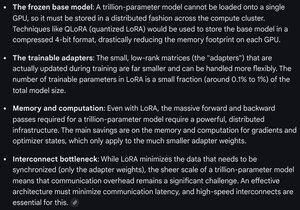

Gemini về yêu cầu tính toán cho LoRA trên một mô hình biên giới - vẫn rất đáng kể, nhưng số lượng tham số được sử dụng ít hơn 1% tổng kích thước mô hình (đào tạo trước).

3,79K

Hàng đầu

Thứ hạng

Yêu thích