Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

John Schulman i Thinking Machines: LoRA bez żalu

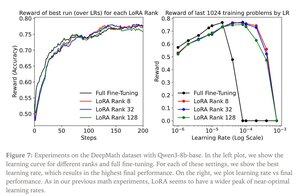

LoRA zastępuje każdą macierz wag W z oryginalnego modelu zmodyfikowaną wersją W’=W+γBA, gdzie B i A to macierze, które razem mają znacznie mniej parametrów niż W.

LoRA działa podobnie do pełnego dostrajania, gdy:

1. LoRA jest stosowana do wszystkich warstw sieci, szczególnie warstw MLP/MoE, które zawierają większość parametrów.

2. LoRA nie jest ograniczona pojemnością, tzn. liczba trenowalnych parametrów przekracza ilość informacji do nauczenia, co można oszacować w odniesieniu do rozmiaru zbioru danych.

Implikacje: Duże modele bazowe (np. o bilionie parametrów) mogą być dostosowywane za ułamek kosztów szkolenia nowego modelu.

Post Thinking Machines:

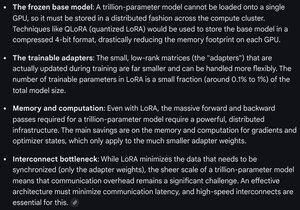

Gemini na temat wymagań obliczeniowych dla LoRA w modelu frontier - nadal ogromne, ale liczba użytych parametrów stanowi mniej niż 1% całkowitego rozmiaru modelu (wstępne szkolenie).

7,93K

Najlepsze

Ranking

Ulubione