Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

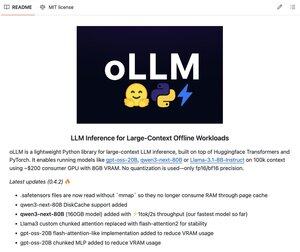

oLLM är ett enkelt Python-bibliotek för lokal LLM-inferens med stor kontext.

Kör gpt-oss-20B, Qwen3-next-80B, Llama-3.1-8B på ~$200 konsument-GPU med bara 8 GB VRAM. Och detta är utan någon kvantisering - endast fp16/bf16 precision.

100% öppen källkod.

Topp

Rankning

Favoriter