Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

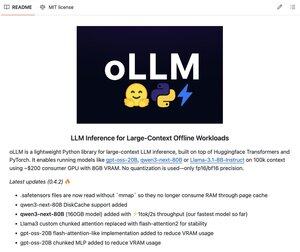

oLLM este o bibliotecă Python ușoară pentru inferența LLM locală în context mare.

Rulați gpt-oss-20B, Qwen3-next-80B, Llama-3.1-8B pe GPU de consum de ~200 USD cu doar 8 GB VRAM. Și asta fără nicio cuantificare - doar precizie fp16/bf16.

100% Opensource.

Limită superioară

Clasament

Favorite