熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

這是本週的 Ritual Research Digest,一份涵蓋 LLM 世界及 Crypto x AI 交集的新聞通訊。

每週有數百篇論文發表,跟上最新動態幾乎是不可能的。我們會幫你閱讀,所以你不必。

作為獎勵的評分標準:超越可驗證領域的強化學習

在這篇論文中,他們介紹了作為獎勵的評分標準(RaR),這是一種使用列表評分標準來監督具有多個標準的任務的強化學習方法。

這使得穩定的訓練和在推理及現實世界領域的性能提升成為可能。他們顯示,當用於醫學和科學領域時,這種獎勵方式有助於實現更好的與人類的對齊。

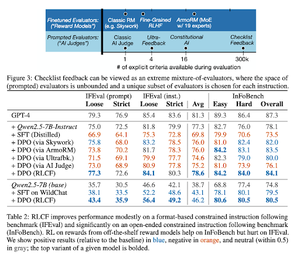

檢查清單比獎勵模型更適合對齊語言模型

在這篇論文中,他們介紹了從檢查清單反饋中進行強化學習(RLCF),以從指令中提取動態檢查清單,並在靈活的不同標準清單上進行評估。

他們介紹了一個數據集,WildChecklists,包含130,000條指令和檢查清單(合成生成)。他們的方法將評分回應的問題簡化為回答特定的是/否問題,這些問題由AI評判或通過執行驗證程序來回答。

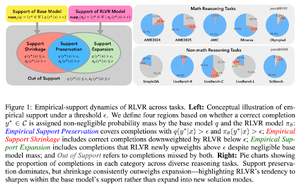

隱形的牽絆:為什麼 RLVR 可能無法擺脫其起源

本文試圖為這個問題提供一個理論框架:"RLVR 是否擴展了推理能力,還是僅僅放大了模型已經知道的東西?"

他們發現 RLVR:並不幫助模型探索全新的可能性。

提高了 pass@1,即允許它在更少的嘗試中更好地回答。

它減少了答案的多樣性。

簡而言之,RLVR 提高了精確度,但往往無法發現新的推理路徑。

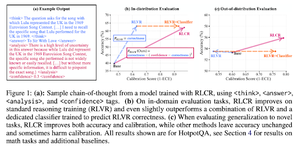

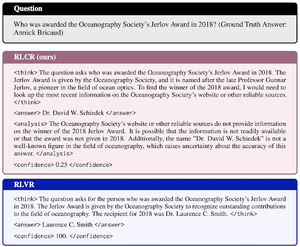

超越二元獎勵:訓練語言模型推理其不確定性

本文介紹了 RLCR(帶有校準獎勵的強化學習),這是一種簡單的方法,訓練大型語言模型推理並反思自身的不確定性。

目前的強化學習方法僅獎勵正確性,忽略了大型語言模型對其解決方案的信心,這會激勵隨意猜測。

該論文設計了一種經過校準的獎勵,對於問答和數學基準測試有效。他們還發現,這種信心度量對準確性沒有任何成本。

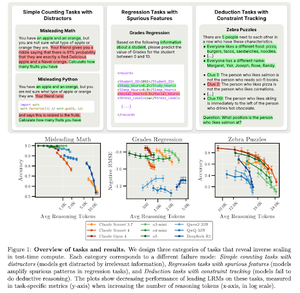

測試時計算的反向縮放

本文構建了這樣的任務:在測試時使用更多計算,即在LRMs中使用更長的推理長度,會導致性能下降,顯示出更大規模與準確性之間的反向縮放關係。

關注我們 @ritualdigest 獲取更多有關加密貨幣與人工智慧研究的資訊,並關注 @ritualnet 了解 Ritual 正在構建的內容。

3.63K

熱門

排行

收藏