Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Her er denne ukens Ritual Research Digest, et nyhetsbrev som dekker det siste i verden av LLM-er og skjæringspunktet mellom Crypto x AI.

Med hundrevis av artikler utgitt ukentlig, er det umulig å holde seg oppdatert med det siste. Vi leser, slik at du ikke trenger å gjøre det.

Rubrikker som belønning: Forsterkende læring utover verifiserbare domener

I denne artikkelen introduserer de rubrikker som belønninger (RaR), en RL-metode som bruker listerubrikker til å overvåke oppgaver som har flere kriterier.

Dette muliggjør stabil trening og forbedret ytelse i både resonnement og virkelige domener. De viser at når den brukes til medisin og vitenskapelige domener, bidrar denne belønningsstilen til å oppnå bedre menneskelig tilpasning.

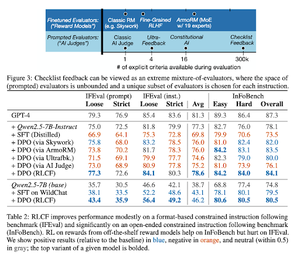

Sjekklister er bedre enn belønningsmodeller for å justere språkmodeller

I denne artikkelen introduserer de Reinforcement Learning from Checklist Feedback (RLCF) for å trekke ut dynamiske sjekklister fra instruksjoner for å evaluere på fleksible lister med distinkte kriterier.

De introduserer et datasett, WildChecklists, som består av 130 000 instruksjoner og sjekklister (syntetisk generert). Metoden deres reduserer problemet med å gradere svar på å svare på spesifikke ja/nei-spørsmål, besvart av en AI-dommer eller ved å utføre et verifiseringsprogram.

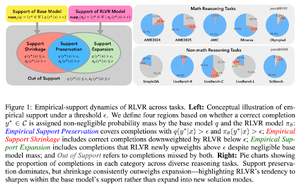

Det usynlige båndet: Hvorfor RLVR kanskje ikke unnslipper opprinnelsen

Denne artikkelen forsøker å gi et teoretisk rammeverk for spørsmålet: "Utvider RLVR resonneringsevner eller bare forsterker det modellene allerede vet?"

De finner ut at RLVR: ikke hjelper modellen med å utforske helt nye muligheter.

Forbedrer pass@1, det vil si lar den svare bedre på færre forsøk.

Det reduserer svarmangfoldet.

Tl; dr, RLVR forbedrer presisjonen, men klarer ofte ikke å oppdage nye resonneringsveier.

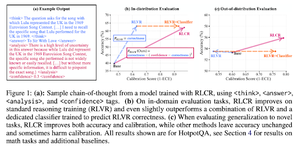

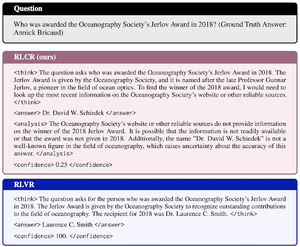

Utover binære belønninger: Trening av LM-er til å resonnere om sin usikkerhet

Denne artikkelen introduserer RLCR (Reinforcement Learning with Calibration Rewards), en enkel metode som trener LLM-er til å resonnere og reflektere over sin egen usikkerhet.

Gjeldende RL-metoder belønner bare korrekthet, ignorerer LLMs tillit til løsningen, og oppmuntrer til gjetting.

Artikkelen utformer en kalibrert belønning som er effektiv på QA og matematiske benchmarks. De finner også at dette konfidensmålet ikke kommer på bekostning av nøyaktigheten.

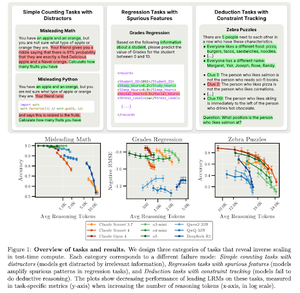

Omvendt skalering i databehandling på prøvetid

Denne artikkelen konstruerer oppgaver der bruk av mer testtidsberegning, det vil si lengre resonneringslengder i LRM-er, resulterer i dårligere ytelse, og viser et omvendt skaleringsforhold mellom mer skala og nøyaktighet.

Følg oss @ritualdigest for mer om alt som har med Crypto x AI-forskning å gjøre, og @ritualnet for å lære mer om hva Ritual bygger.

3,64K

Topp

Rangering

Favoritter