Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier ist der Ritual Research Digest dieser Woche, ein Newsletter, der die neuesten Entwicklungen in der Welt der LLMs und der Schnittstelle von Crypto x AI abdeckt.

Bei Hunderten von wöchentlich veröffentlichten Arbeiten ist es unmöglich, mit den neuesten Entwicklungen Schritt zu halten. Wir werden die Lektüre übernehmen, damit Sie es nicht müssen.

Rubriken als Belohnungen: Verstärkendes Lernen über verifizierbare Bereiche hinaus

In diesem Papier stellen sie Rubriken als Belohnungen (RaR) vor, eine RL-Methode, die Listenrubriken verwendet, um Aufgaben zu überwachen, die mehrere Kriterien haben.

Dies ermöglicht ein stabiles Training und eine verbesserte Leistung sowohl in den Bereichen des Denkens als auch in der realen Welt. Sie zeigen, dass diese Art von Belohnungen, wenn sie in den Bereichen Medizin und Wissenschaft eingesetzt wird, dazu beiträgt, eine bessere menschliche Ausrichtung zu erreichen.

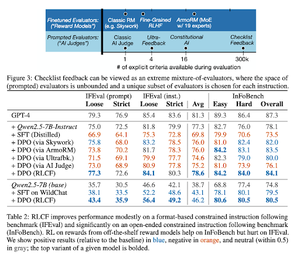

Checklisten sind besser als Belohnungsmodelle zur Ausrichtung von Sprachmodellen

In diesem Papier wird Reinforcement Learning aus Checklisten-Feedback (RLCF) eingeführt, um dynamische Checklisten aus Anweisungen zu extrahieren, um auf flexiblen Listen von unterschiedlichen Kriterien zu bewerten.

Sie führen einen Datensatz, WildChecklists, ein, der aus 130.000 Anweisungen und Checklisten (synthetisch generiert) besteht. Ihre Methode reduziert das Problem der Bewertung von Antworten auf die Beantwortung spezifischer Ja/Nein-Fragen, die von einem KI-Richter oder durch Ausführen eines Verifizierungsprogramms beantwortet werden.

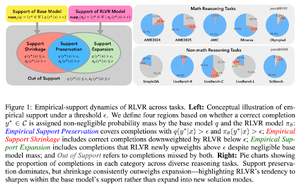

Die unsichtbare Leine: Warum RLVR möglicherweise nicht aus seiner Herkunft entkommen kann

Dieses Papier versucht, einen theoretischen Rahmen für die Frage bereitzustellen: "Erweitert RLVR die Denkfähigkeiten oder verstärkt es nur, was Modelle bereits wissen?"

Sie stellen fest, dass RLVR: das Modell nicht dabei hilft, völlig neue Möglichkeiten zu erkunden.

Verbessert pass@1, d.h. es ermöglicht, besser in weniger Versuchen zu antworten.

Es reduziert die Antwortvielfalt.

tl;dr, RLVR verbessert die Präzision, entdeckt jedoch oft keine neuen Denkansätze.

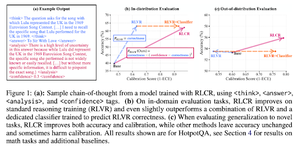

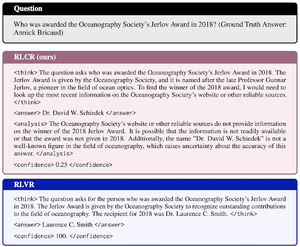

Über binäre Belohnungen hinaus: LMs trainieren, um über ihre Unsicherheit nachzudenken

Dieses Papier stellt RLCR (Reinforcement Learning mit Kalibrierungsbelohnungen) vor, eine einfache Methode, die LLMs trainiert, um über ihre eigene Unsicherheit nachzudenken und zu reflektieren.

Aktuelle RL-Methoden belohnen nur die Richtigkeit und ignorieren das Vertrauen des LLM in seine Lösung, was das Raten anreizt.

Das Papier entwirft eine kalibrierte Belohnung, die bei QA- und Mathematik-Benchmarks effektiv ist. Sie stellen auch fest, dass dieses Vertrauensmaß keine Kosten für die Genauigkeit mit sich bringt.

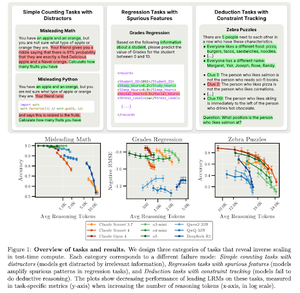

Inverse Skalierung bei der Berechnung zur Testzeit

Dieses Papier konstruiert Aufgaben, bei denen die Verwendung von mehr Rechenzeit während des Tests, d.h. längeren Schlussfolgerungslängen in LRMs, zu schlechteren Leistungen führt und eine inverse Skalierungsbeziehung zwischen mehr Skalierung und Genauigkeit zeigt.

Folge uns @ritualdigest für mehr über alles, was mit Crypto x AI-Forschung zu tun hat, und @ritualnet, um mehr darüber zu erfahren, was Ritual aufbaut.

3,78K

Top

Ranking

Favoriten