Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Zde je tento týden Ritual Research Digest, zpravodaj pokrývající nejnovější ve světě LLM a průnik Crypto x AI.

Se stovkami novin publikovaných týdně je nemožné mít přehled o těch nejnovějších. Odečteme vás, takže vy nemusíte.

Rubriky jako odměny: Zpětnovazební učení mimo ověřitelné domény

V tomto článku představují rubriky jako odměny (RaR), metodu RL, která používá rubriky Seznam k dohledu nad úkoly, které mají více kritérií.

To umožňuje stabilní trénink a lepší výkon jak v oblasti uvažování, tak v doménách reálného světa. Ukazují, že když se tento styl odměn používá pro medicínu a vědu, pomáhá dosáhnout lepšího lidského souladu.

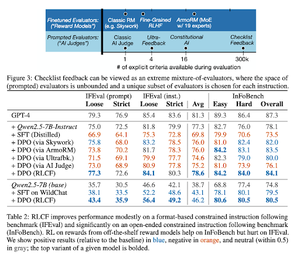

Kontrolní seznamy jsou lepší než modely odměn pro sladění jazykových modelů

V tomto článku představují zpětnovazební učení ze zpětné vazby kontrolního seznamu (RLCF) pro extrahování dynamických kontrolních seznamů z instrukcí pro vyhodnocení na flexibilních seznamech odlišných kritérií.

Zavádějí datovou sadu, WildChecklists, obsahující 130 000 instrukcí a checklistů (synteticky generovaných). Jejich metoda snižuje problém hodnocení odpovědí na odpovědi na konkrétní otázky ano/ne, zodpovězené porotcem s umělou inteligencí nebo provedením ověřovacího programu.

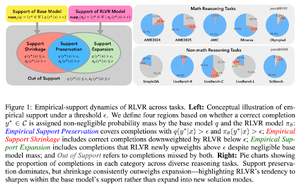

Neviditelné vodítko: Proč RLVR nemusí uniknout svému původu

Tento článek se pokouší poskytnout teoretický rámec pro otázku: "Rozšiřuje RLVR možnosti uvažování nebo jen rozšiřuje to, co modely již vědí?"

Zjistili, že RLVR: nepomáhá modelu prozkoumat zcela nové možnosti.

Vylepšuje pass@1, tj. umožňuje mu lépe reagovat na méně pokusů.

Snižuje rozmanitost odpovědí.

Tl; dr, RLVR zlepšuje přesnost, ale často selhává v objevování nových rozumových cest.

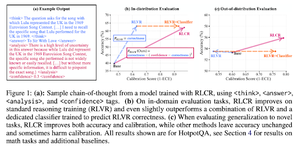

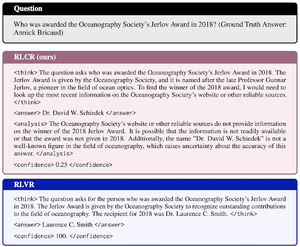

Víc než binární odměny: Školení LM v uvažování o své nejistotě

Tento článek představuje RLCR (Reinforcement Learning with Calibration Rewards), přímočarou metodu, která učí LLM uvažovat a reflektovat svou vlastní nejistotu.

Současné metody RL odměňují pouze správnost, ignorují důvěru LLM ve své řešení a motivují k hádání.

Článek navrhuje kalibrovanou odměnu, která je účinná na základě QA a matematických benchmarků. Zjistili také, že toto měřítko spolehlivosti není na úkor přesnosti.

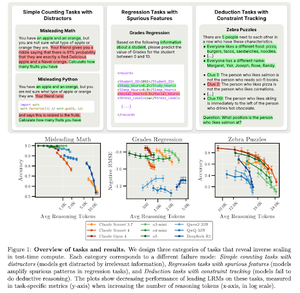

Inverzní škálování ve výpočtech v době testování

Tento článek konstruuje úlohy, kde použití většího počtu testovacích časů, tj. delších délek uvažování v LRM, vede k horšímu výkonu, což vykazuje inverzní škálovací vztah mezi větším rozsahem a přesností.

Sledujte nás @ritualdigest pro více informací o všem, co se týká výzkumu Crypto x AI, a @ritualnet se dozvíte více o tom, co Ritual buduje.

3,64K

Top

Hodnocení

Oblíbené