Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ось Ritual Research Digest цього тижня, інформаційний бюлетень, який висвітлює найновіші у світі LLM та перетин Crypto x AI.

З сотнями газет, що публікуються щотижня, залишатися в курсі останніх неможливо. Ми прочитаємо, щоб вам не довелося.

Рубрики як винагорода: навчання з підкріпленням за межами перевірених доменів

У цій статті вони вводять рубрики як винагороди (RaR), метод RL, який використовує рубрики списку для контролю за завданнями, які мають кілька критеріїв.

Це забезпечує стабільне навчання та покращення продуктивності як у міркуваннях, так і в реальних сферах. Вони показують, що при використанні в медицині та науці цей стиль винагород допомагає досягти кращого пристосування людей.

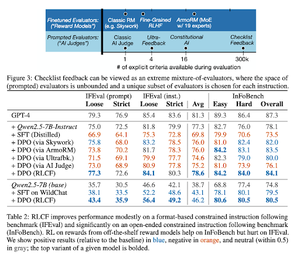

Чек-листи кращі, ніж моделі винагород для вирівнювання мовних моделей

У цій статті вони вводять Reinforcement Learning from Checklist Feedback (RLCF) для вилучення динамічних контрольних списків з інструкцій для оцінювання за гнучкими списками чітких критеріїв.

Вони представляють набір даних, WildChecklists, що складається з 130 000 інструкцій і контрольних списків (синтетично згенерованих). Їхній метод зводить проблему оцінювання відповідей до відповідей на конкретні запитання «так/ні», на які відповідає суддя зі штучним інтелектом або за допомогою виконання програми верифікації.

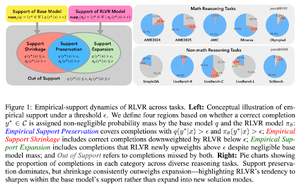

Невидимий повідець: чому RLVR може не втекти від свого походження

У цій статті зроблена спроба дати теоретичну основу для питання: «Чи розширює RLVR можливості міркування або просто підсилює те, що вже знають моделі?»

Вони вважають, що RLVR: не допомагає моделі досліджувати абсолютно нові можливості.

Покращує pass@1, тобто дозволяє йому краще відповідати за меншу кількість спроб.

Це зменшує різноманітність відповідей.

тл; dr, RLVR підвищує точність, але часто не відкриває нових шляхів міркування.

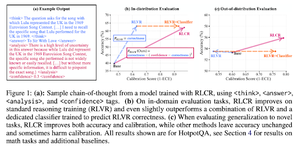

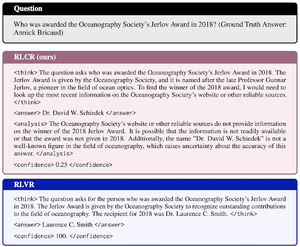

За межами бінарних винагород: навчання LM міркувати про свою невпевненість

У цій статті представлено RLCR (Reinforcement Learning with Calibration Rewards), простий метод, який тренує LLM міркувати та розмірковувати про власну невизначеність.

Сучасні методи РЛ винагороджують лише правильність, ігноруючи впевненість ЛЛМ у своєму розв'язанні, заохочуючи вгадування.

У документі розроблено калібровану винагороду, яка ефективна на тестах QA та математики. Вони також виявляють, що цей показник впевненості є безкоштовним для точності.

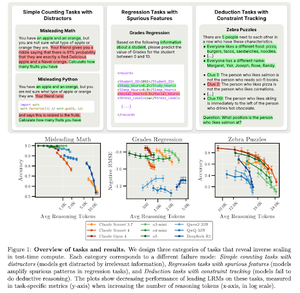

Обернене масштабування в обчисленнях під час тестування

Ця стаття будує завдання, в яких використання більшого часу обчислень тестового часу, тобто більшої довжини міркувань у LRM, призводить до гіршої продуктивності, демонструючи обернену залежність масштабування між більшим масштабом і точністю.

Слідкуйте за нами @ritualdigest, щоб дізнатися більше про дослідження Crypto x AI, а @ritualnet дізнатися більше про те, що створює Ritual.

3,75K

Найкращі

Рейтинг

Вибране