Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Oto najnowszy Digest Ritual Research, newsletter obejmujący najnowsze wydarzenia w świecie LLM-ów oraz na styku Crypto x AI.

Z setkami publikacji co tydzień, niemożliwe jest nadążanie za nowinkami. My przeczytamy, abyś ty nie musiał.

Rubryki jako Nagrody: Uczenie się przez Wzmocnienie poza Weryfikowalnymi Obszarami

W tym artykule wprowadzają Rubryki jako Nagrody (RaR), metodę RL, która wykorzystuje rubryki listowe do nadzorowania zadań, które mają wiele kryteriów.

To umożliwia stabilne szkolenie i poprawioną wydajność zarówno w dziedzinie rozumowania, jak i w rzeczywistych zastosowaniach. Pokazują, że gdy jest stosowane w dziedzinach medycyny i nauki, ten styl nagród pomaga osiągnąć lepsze dostosowanie do ludzi.

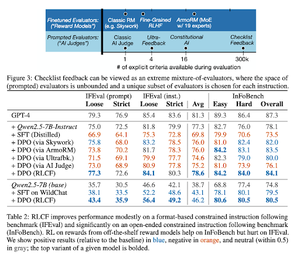

Listy kontrolne są lepsze niż modele nagród do dostosowywania modeli językowych

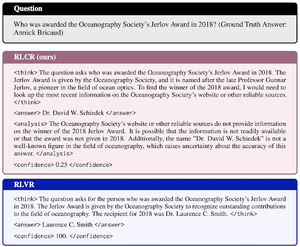

W tym artykule wprowadzają Uczenie przez Wzmocnienie z Informacjami zwrotnymi z Listy Kontrolnej (RLCF), aby wydobyć dynamiczne listy kontrolne z instrukcji do oceny na elastycznych listach różnych kryteriów.

Wprowadzają zbiór danych, WildChecklists, składający się z 130 000 instrukcji i list kontrolnych (syntetycznie generowanych). Ich metoda redukuje problem oceniania odpowiedzi do odpowiadania na konkretne pytania tak/nie, na które odpowiada sędzia AI lub poprzez uruchomienie programu weryfikacyjnego.

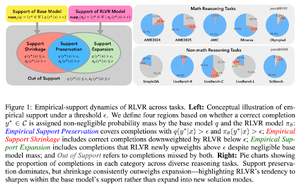

Niewidzialna smycz: Dlaczego RLVR może nie uciec od swojego pochodzenia

Niniejszy artykuł stara się dostarczyć teoretycznego ramy dla pytania: „Czy RLVR rozszerza zdolności rozumowania, czy tylko wzmacnia to, co modele już wiedzą?”

Oni stwierdzają, że RLVR: nie pomaga modelowi w odkrywaniu zupełnie nowych możliwości.

Poprawia pass@1, tzn. pozwala na lepsze odpowiedzi w mniejszej liczbie prób.

Redukuje różnorodność odpowiedzi.

Podsumowując, RLVR poprawia precyzję, ale często nie udaje mu się odkryć nowych ścieżek rozumowania.

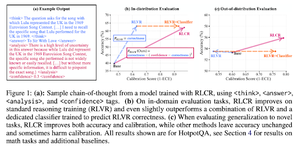

Poza nagrodami binarnymi: Szkolenie LM do rozumienia swojej niepewności

Niniejszy artykuł wprowadza RLCR (Uczenie przez Wzmocnienie z Nagrodami Kalibracyjnymi), prostą metodę, która szkoli LLM do rozumienia i refleksji nad własną niepewnością.

Obecne metody RL nagradzają tylko poprawność, ignorując pewność LLM w swoim rozwiązaniu, co zachęca do zgadywania.

Artykuł projektuje skalibrowaną nagrodę, która jest skuteczna w benchmarkach QA i matematycznych. Odkrywają również, że ten wskaźnik pewności nie wpływa na dokładność.

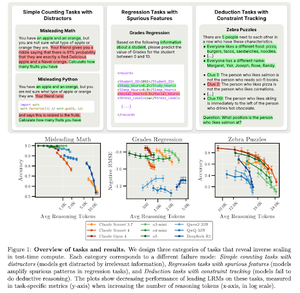

Skalowanie odwrotne w obliczeniach w czasie testu

Niniejszy artykuł konstruuje zadania, w których wykorzystanie większej mocy obliczeniowej w czasie testu, tj. dłuższe długości rozumowania w LRM, skutkuje gorszą wydajnością, wykazując odwrotną zależność między większą skalą a dokładnością.

Śledź nas @ritualdigest, aby uzyskać więcej informacji na temat wszystkiego, co związane z badaniami Crypto x AI, oraz @ritualnet, aby dowiedzieć się więcej o tym, co buduje Ritual.

3,64K

Najlepsze

Ranking

Ulubione