热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

Prime-rl 现在对 MoE 提供了广泛的支持,适用于 RL 和 SFT,我们已经用它训练了 100B+ 模型。

我们支持:

* Qwen3 a3-30b

* GLM 系列和 Moonlight

* 正在添加 gpt oss 系列。

我们最终重写了大部分建模代码,以使其与 torch compile 兼容,同时仍然与 hugging face 生态系统兼容。

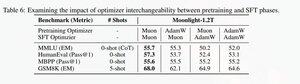

我们还增加了对 glm 系列进行微调的支持,因为我们发现这使得在 muon 预训练模型上的训练更加稳定。这与 moonlight 论文中的发现非常相关。

我们正在使用 Microsoft 在 dion 中的实现。

在性能方面,我们与torchtitan moe训练不相上下(主要是因为我们以torchtitan作为优化代码的参考)。

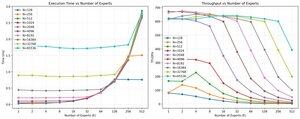

我们在512 h200 GPU上使用muon进行65K序列长度训练时,在100B glm air moe上达到了20%的mfu。在并行性方面,我们发现torchtitan EP对于稀疏MoE的优化并不明显,并且在足够大的批量大小下没有带来任何有意义的加速。

我们似乎可以很快饱和MoE的group mm内核性能,并且在EP中进行更好的负载平衡由于全到全的阻塞而收益递减。

我们相信,在开源MoE堆栈中还有很多改进的空间。迫切需要优化内核以加快MoE的速度,并以非常细粒度的方式隐藏通信和计算。对于blackwell来说,这种需求似乎更加迫切。

啊,实际上大部分关于moe的工作都是由@jackminong完成的。

18.03K

热门

排行

收藏