Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl heeft nu uitgebreide ondersteuning voor MoE, zowel voor RL als SFT. We hebben een model van meer dan 100B getraind met het.

We hebben ondersteuning voor:

* Qwen3 a3-30b

* GLM-serie en Moonlight

* we zijn bezig met het toevoegen van de gpt oss-serie.

We eindigen met het herschrijven van het meeste modelleer-code om het te laten werken met torch compile, terwijl het nog steeds compatibel is met het hugging face-ecosysteem.

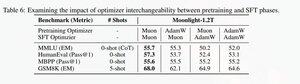

We hebben ook ondersteuning toegevoegd om de glm-serie te finetunen met Muon, omdat we hebben ontdekt dat het de training veel stabieler maakt op het muon pretrain-model. Dit komt goed overeen met de bevindingen in het moonlight-paper.

We gebruiken de Microsoft-implementatie in dion

Wat betreft prestaties zijn we gelijkwaardig aan torchtitan moe training (voornamelijk omdat we torchtitan als referentie hebben genomen voor het optimaliseren van onze code).

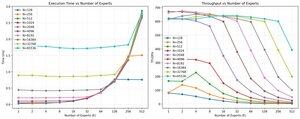

We bereiken 20% mfu op de 100B glm air moe bij 65K seq len training op 512 h200 gpu met muon. Wat betreft parallelisme hebben we ontdekt dat torchtitan EP niet zo goed is geoptimaliseerd voor sparse MoEs en het heeft geen significante versnelling opgeleverd met een grote genoeg batchgrootte.

Het lijkt erop dat we de prestaties van de group mm kernel voor MoEs vrij snel kunnen verzadigen en dat beter load balancing met EP afnemende rendementen oplevert vanwege de blocking all to all.

We geloven dat er veel ruimte is voor verbetering in de open source stack voor MoEs. Er is een sterke behoefte aan geoptimaliseerde kernels om MoEs sneller te maken en om communicatie en berekening op een zeer fijnmazige manier te verbergen. Het lijkt zelfs nog meer nodig te zijn voor blackwell.

ah, ook het meeste werk aan moe is gedaan door @jackminong

19,94K

Boven

Positie

Favorieten