Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl ahora tiene un amplio soporte para MoE tanto para RL como para SFT, hemos estado entrenando el modelo 100B + con él

Tenemos soporte para:

* Qwen3 a3-30b

* Serie GLM y Moonlight

* Agregar la serie GPT OSS mientras hablamos

Terminamos reescribiendo la mayor parte del código de modelado para que funcione con Torch Compile sin dejar de ser compatible con el ecosistema Hugging Face

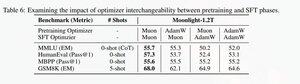

También agregamos soporte para ajustar la serie glm con Muon, ya que descubrimos que hace que el entrenamiento sea mucho más estable en el modelo de preentrenamiento de muones. Esto se correlaciona bien con el hallazgo en el artículo de la luz de la luna.

Estamos usando la implementación de Microsoft en dion

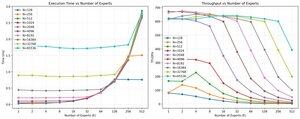

En cuanto al rendimiento, estamos a la par con el entrenamiento de torchtitan moe (principalmente porque tomamos torchtitan como referencia para optimizar nuestro código).

Alcanzamos el 20% de mfu en el moe de aire de 100B glm a 65K seq len de entrenamiento en gpu 512 h200 con muón. En términos de paralelismo, descubrimos que torchtitan EP no está tan optimizado para MoE dispersos y no produjo ninguna aceleración significativa con un tamaño de lote lo suficientemente grande.

Parece que podemos saturar el rendimiento del kernel del grupo mm para MoE bastante rápido y que hacer un mejor equilibrio de carga con EP produce un rendimiento decreciente debido al bloqueo de todos a todos.

Creemos que hay mucho margen de mejora en la pila de código abierto para MoE. Existe una gran necesidad de kernels optimizados para hacer que los MoE sean más rápidos y para ocultar la comunicación y la computación de una manera muy fina. Parece ser aún más necesario para Blackwell

ah también la mayor parte del trabajo sobre moe ha sido realizado por @jackminong

20.88K

Populares

Ranking

Favoritas