Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rl má nyní rozsáhlou podporu MoE jak pro RL, tak pro SFT, trénovali jsme s ním model 100B+

Máme podporu pro:

* Qwen3 a3-30b

* Řada GLM a Moonlight

* Přidáváme GPT OSS sérii, jak mluvíme

Nakonec přepíšeme většinu kódu modelování, aby fungoval s Torch Compile a zároveň byl kompatibilní s ekosystémem Hugging Face

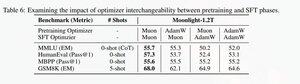

Přidali jsme také podporu pro vyladění řady glm pomocí Muonu, protože jsme zjistili, že je trénování na modelu předtrénování mionu stabilnější. To dobře koreluje s nálezem v měsíčním papíře.

Používáme implementaci od Microsoftu v dionu

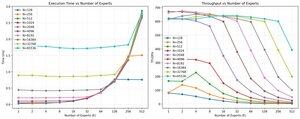

Z hlediska výkonu jsme na stejné úrovni jako torchtitan moe training (hlavně proto, že jsme torchtitanium vzali jako referenci pro optimalizaci našeho kódu).

Dosahujeme 20 % mfu na 100B glm air moe při 65K seq len tréninku na 512 h200 GPU s mionem. Z hlediska paralelismu jsme zjistili, že torchtitan EP není až tak moc optimalizovaný pro řídké MoE a nepřinesl žádné smysluplné zrychlení s dostatečně velkou velikostí šarže.

Zdá se, že výkon jádra skupiny mm pro MoE můžeme poměrně rychle nasytit a že lepší vyvažování zátěže s EP přináší klesající návratnost kvůli blokování all to all.

Věříme, že v celém open source stacku pro MoE je velký prostor pro zlepšení. Existuje silná potřeba optimalizovaných jader, aby byly MoE rychlejší a aby se komunikace a výpočty skryly velmi jemnězrnným způsobem. Zdá se, že je ještě více potřebný pro Blackwell

Aha, také většinu práce na MOE odvedli @jackminong

18,04K

Top

Hodnocení

Oblíbené