トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime-rlは現在、RLとSFTの両方でMoEを幅広くサポートしており、100B+モデルをトレーニングしています

以下をサポートします。

* Qwen3 a3-30b

* GLMシリーズとムーンライト

*私たちが話しているようにGPTOSSシリーズを追加します

最終的には、ほとんどのモデリングコードを書き直して、Hugging Faceエコシステムと互換性を保ちながらTorch Compileで動作するようにします

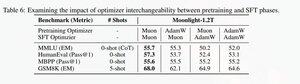

また、muonプレトレインモデルでのトレーニングをより安定させることがわかったため、Muonを使用してglmシリーズを微調整するためのサポートも追加しました。これは月明かりの論文で発見したこととよく相関しています。

dion の Microsoft 実装を使用しています

パフォーマンス的には、torchtitan moe トレーニングと同等です (主にコードを最適化するためのリファレンスとして torchtitan を使用したため)。

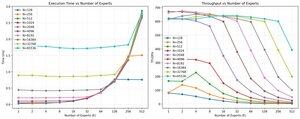

ミューオンを使用した 512 h200 gpu での 65K シーケンス レンジ トレーニングで、100B glm エア モーで 20% mfu に達します。 並列処理に関しては、torchtitan EP はスパース MoE に対してそれほど最適化されておらず、十分な大きさのバッチ サイズでは意味のある高速化が得られないことがわかりました。

MoEのグループmmカーネルのパフォーマンスを非常に速く飽和させることができ、EPでロードバランシングを改善すると、すべてをブロックするため、収益が減少するようです。

MoEのオープンソーススタック全体には改善の余地がたくさんあると考えています。MoEを高速化し、通信と計算を非常にきめ細かい方法で隠すために、最適化されたカーネルの必要性が強く求められています。ブラックウェルにはさらに必要とされそうです

ああ、萌えに関する作業のほとんどは@jackminongによって行われました

13.71K

トップ

ランキング

お気に入り