Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

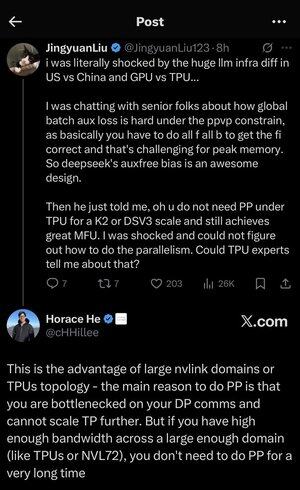

Tôi đã hơi lạc trong tất cả các từ viết tắt và thuật ngữ ở đây, vì vậy tôi đã nhờ Claude giải thích mà không sử dụng bất kỳ từ viết tắt nào và bây giờ mọi thứ đều có ý nghĩa hoàn hảo (tóm tắt; băng thông ⟹ sự đơn giản):

Đây là một cuộc thảo luận kỹ thuật thú vị về việc đào tạo các mô hình ngôn ngữ lớn quy mô lớn.

Cuộc trò chuyện chính

Jingyuan Liu đang bày tỏ sự ngạc nhiên khi phát hiện ra rằng bạn không cần một số kỹ thuật tối ưu hóa phức tạp khi sử dụng TPU (Bộ xử lý Tensor - chip AI chuyên dụng của Google) so với GPU (Bộ xử lý Đồ họa - thường là chip của NVIDIA).

Các khái niệm kỹ thuật chính được giải thích:

Các loại phần cứng:

• GPU (Bộ xử lý Đồ họa): Ban đầu được thiết kế cho đồ họa, giờ đây được sử dụng nhiều cho AI. NVIDIA thống trị thị trường này.

• TPU (Bộ xử lý Tensor): Chip được thiết kế riêng của Google dành riêng cho học máy.

Chiến lược song song:

Khi đào tạo các mô hình AI khổng lồ, bạn cần chia công việc giữa nhiều chip. Có một số cách để làm điều này:

1) Song song dữ liệu (DP): Mỗi chip xử lý các lô dữ liệu khác nhau với cùng một bản sao mô hình

2) Song song tensor (TP): Các phép toán toán học của mô hình được chia sẻ giữa các chip

3) Song song ống dẫn (PP): Các lớp khác nhau của mô hình được đặt trên các chip khác nhau, tạo thành một ống dẫn

Thách thức kỹ thuật đang được thảo luận:

Vấn đề mất mát phụ: Khi đào tạo các mô hình rất lớn, bạn thường thêm "mất mát phụ" (các mục tiêu đào tạo bổ sung) ở các lớp trung gian để giúp các gradient chảy tốt hơn qua mạng. Dưới các ràng buộc PPVP (Song song ống dẫn với phân vùng biến đổi), điều này trở nên phức tạp vì:

...

Hàng đầu

Thứ hạng

Yêu thích