Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

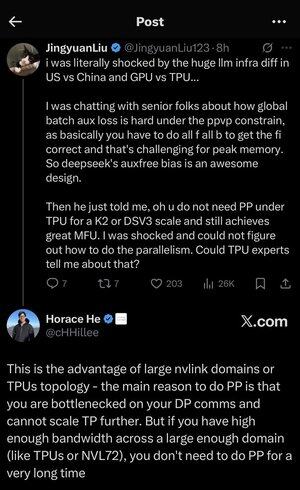

Me perdí un poco en todos los acrónimos y jerga aquí, así que hice que Claude lo explicara sin usar acrónimos y ahora todo tiene perfecto sentido (resumen; ancho de banda ⟹ simplicidad):

Esta es una fascinante discusión técnica sobre el entrenamiento de modelos de lenguaje grandes a gran escala.

La Conversación Principal

Jingyuan Liu expresa sorpresa al descubrir que no necesitas ciertas técnicas de optimización complejas al usar TPUs (Unidades de Procesamiento de Tensores - los chips de IA especializados de Google) en comparación con GPUs (Unidades de Procesamiento Gráfico - típicamente chips de NVIDIA).

Conceptos Técnicos Clave Explicados:

Tipos de Hardware:

•GPU (Unidad de Procesamiento Gráfico): Originalmente diseñada para gráficos, ahora se utiliza mucho para IA. NVIDIA domina este mercado.

•TPU (Unidad de Procesamiento de Tensores): Chips diseñados a medida por Google específicamente para aprendizaje automático.

Estrategias de Paralelismo:

Al entrenar modelos de IA masivos, necesitas dividir el trabajo entre muchos chips. Hay varias formas de hacerlo:

1) Paralelismo de Datos (DP): Cada chip procesa diferentes lotes de datos con la misma copia del modelo.

2) Paralelismo de Tensores (TP): Las operaciones matemáticas del modelo se dividen entre chips.

3) Paralelismo en Pipeline (PP): Diferentes capas del modelo se colocan en diferentes chips, creando un pipeline.

El Desafío Técnico que se Está Discutiendo:

El problema de la pérdida auxiliar: Al entrenar modelos muy grandes, a menudo agregas "pérdidas auxiliares" (objetivos de entrenamiento adicionales) en capas intermedias para ayudar a que los gradientes fluyan mejor a través de la red. Bajo las restricciones de PPVP (Paralelismo en Pipeline con Particionamiento Variable), esto se vuelve complejo porque:

...

Parte superior

Clasificación

Favoritos