Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

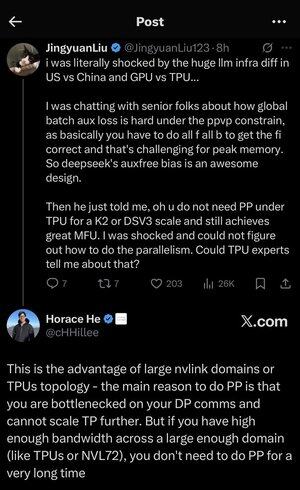

Ik raakte een beetje verdwaald in al de afkortingen en jargon hier, dus vroeg ik Claude het uit te leggen zonder afkortingen en nu maakt het allemaal perfect sense (tldr; bandbreedte ⟹ eenvoud):

Dit is een fascinerende technische discussie over het trainen van grote taalmodellen op schaal.

De Kern Conversatie

Jingyuan Liu uit zijn verbazing over het ontdekken dat je bepaalde complexe optimalisatietechnieken niet nodig hebt bij het gebruik van TPU's (Tensor Processing Units - Google's gespecialiseerde AI-chips) in vergelijking met GPU's (Graphics Processing Units - typisch NVIDIA's chips).

Belangrijke Technische Concepten Uitleg:

Hardware Types:

•GPU (Graphics Processing Unit): Oorspronkelijk ontworpen voor graphics, nu veel gebruikt voor AI. NVIDIA domineert deze markt.

•TPU (Tensor Processing Unit): Google's op maat ontworpen chips specifiek voor machine learning.

Parallelisme Strategieën:

Bij het trainen van enorme AI-modellen moet je het werk over veel chips verdelen. Er zijn verschillende manieren om dit te doen:

1) Data Parallelisme (DP): Elke chip verwerkt verschillende batches gegevens met dezelfde modelkopie.

2) Tensor Parallelisme (TP): De wiskundige operaties van het model worden over chips verdeeld.

3) Pipeline Parallelisme (PP): Verschillende lagen van het model worden op verschillende chips geplaatst, waardoor een pijplijn ontstaat.

De Technische Uitdaging Die Wordt Besproken:

Het probleem van de aanvullende verliesfunctie: Bij het trainen van zeer grote modellen voeg je vaak "aanvullende verliezen" (extra trainingsdoelen) toe op tussenliggende lagen om de gradiënten beter door het netwerk te laten stromen. Onder PPVP (Pipeline Parallelism with Variable Partitioning) beperkingen wordt dit complex omdat:

...

Boven

Positie

Favorieten