Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

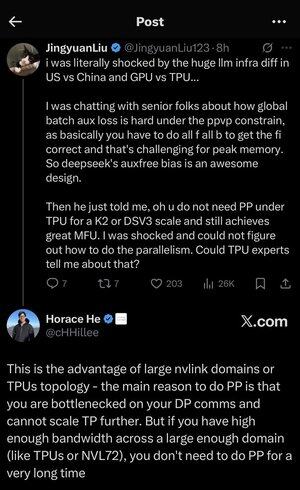

Eu me perdi um pouco em todas as siglas e jargões aqui, então pedi ao Claude que explicasse sem usar nenhuma sigla e agora tudo faz todo o sentido (tldr; largura de banda ⟹ simplicidade):

Esta é uma discussão técnica fascinante sobre o treinamento de grandes modelos de linguagem em escala.

A conversa central

Jingyuan Liu está expressando surpresa ao descobrir que você não precisa de certas técnicas complexas de otimização ao usar TPUs (Tensor Processing Units - chips de IA especializados do Google) versus GPUs (Graphics Processing Units - normalmente chips da NVIDIA).

Principais conceitos técnicos explicados:

Tipos de hardware:

•GPU (Unidade de Processamento Gráfico): Originalmente projetada para gráficos, agora muito usada para IA. A NVIDIA domina esse mercado.

• TPU (Tensor Processing Unit): os chips personalizados do Google especificamente para aprendizado de máquina.

Estratégias de paralelismo:

Ao treinar modelos massivos de IA, você precisa dividir o trabalho em vários chips. Existem várias maneiras de fazer isso:

1) Paralelismo de dados (DP): Cada chip processa diferentes lotes de dados com a mesma cópia do modelo

2) Paralelismo tensorial (TP): As operações matemáticas do modelo são divididas em chips

3) Paralelismo de pipeline (PP): Diferentes camadas do modelo são colocadas em diferentes chips, criando um pipeline

O desafio técnico em discussão:

O problema de perda auxiliar: ao treinar modelos muito grandes, você geralmente adiciona "perdas auxiliares" (objetivos de treinamento adicionais) em camadas intermediárias para ajudar os gradientes a fluir melhor pela rede. Sob restrições de PPVP (paralelismo de pipeline com particionamento variável), isso se torna complexo porque:

...

Melhores

Classificação

Favoritos