Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

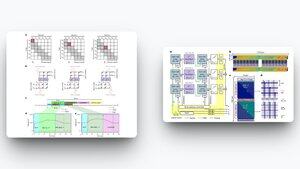

Новая статья в журнале Nature Computational Science представляет аналоговую архитектуру вычислений в памяти (IMC) для трансформеров, которая может сделать LLM до 100 раз быстрее и на 10 000 раз более энергоэффективными, чем современные GPU.

Источник:

Узкое место в LLM не только в математике; это движение памяти.

Каждый новый токен заставляет GPU перемещать огромные KV-кэши между памятью с высокой пропускной способностью и SRAM. Этот постоянный обмен сжигает энергию и добавляет задержку.

Этот новый дизайн меняет правила игры. Используя ячейки памяти на основе заряда, архитектура как хранит проекции токенов, так и вычисляет скалярные произведения в одном и том же месте, устраняя бесконечное перемещение данных.

Ключевые результаты:

↳ Ускорение до 7,000× по сравнению с Jetson Nano, 300× по сравнению с RTX 4090, 100× по сравнению с H100

↳ Употребление энергии до 90,000× ниже по сравнению с GPU

↳ Достигнута точность на уровне GPT-2 без повторной тренировки с нуля

↳ Эффективное с точки зрения аппаратного обеспечения внимание с использованием скользящего окна, которое масштабируется

Если это масштабируется, мы смотрим на мир, где тяжелые LLM не нуждаются в гипермасштабируемых дата-центрах для работы. Вместо этого они могут работать локально на крайних устройствах, ноутбуках, таких как узлы Fizz, и даже на IoT-аппаратном обеспечении, предоставляя быстрые, дешевые и маломощные решения.

Революция в области ИИ будет не только о более умных алгоритмах. Она также будет о новой физике вычислений. Представьте себе GPT-5, работающий в оффлайне, с долей сегодняшних затрат на энергию.

990

Топ

Рейтинг

Избранное