Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

En ny artikkel i Nature Computational Science introduserer en analog in-memory computing (IMC)-arkitektur for transformatorer som kan få LLM-er til å kjøre opptil 100 ganger raskere og 10 000 ganger mer energieffektive enn dagens GPUer.

Kilde:

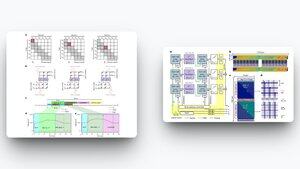

Flaskehalsen i LLM-er er ikke bare matematikk; det er minnebevegelse.

Hvert nytt token tvinger GPUer til å stokke massive KV-cacher mellom minne med høy båndbredde og SRAM. Den konstante frem og tilbake brenner energi og legger til ventetid.

Dette nye designet snur manuset. Ved å bruke ladebaserte forsterkningscelleminner lagrer arkitekturen både tokenprojeksjoner og beregner punktprodukter på samme sted, noe som eliminerer endeløs datastokking.

Viktige resultater:

↳ Opptil 7,000× speedup vs Jetson Nano, 300× vs RTX 4090, 100× vs H100

↳ Opptil 90 000 × lavere energiforbruk sammenlignet med GPUer

↳ GPT-2-nivå nøyaktighet oppnådd uten omskolering fra bunnen av

↳ Maskinvareeffektiv skyvevindusoppmerksomhet som skalerer

Hvis dette skalerer, ser vi på en verden der tunge LLM-er ikke trenger hyperscaler-datasentre for å puste. I stedet kan de kjøre lokalt på edge-enheter, bærbare datamaskiner som Fizz-noder og til og med IoT-maskinvare, noe som gir raske, billige og lavstrømsløsninger.

AI-revolusjonen vil ikke bare handle om smartere algoritmer. Det vil også handle om den nye fysikken til databehandling. Se for deg at GPT-5 kjører offline, til en brøkdel av dagens energikostnader.

2,77K

Topp

Rangering

Favoritter