Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

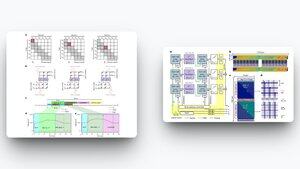

Sebuah makalah baru di Nature Computational Science memperkenalkan arsitektur komputasi dalam memori analog (IMC) untuk transformator yang dapat membuat LLM berjalan hingga 100x lebih cepat dan 10.000x lebih hemat energi daripada GPU saat ini.

Sumber:

Kemacetan dalam LLM bukan hanya matematika; itu adalah gerakan memori.

Setiap token baru memaksa GPU untuk mengocok cache KV besar-besaran antara memori bandwidth tinggi dan SRAM. Bolak-balik yang konstan itu membakar energi dan menambah latensi.

Desain baru ini membalik skrip. Menggunakan memori sel penguatan berbasis muatan, arsitektur menyimpan proyeksi token dan menghitung produk titik di tempat yang sama, menghilangkan pengocok data tanpa akhir.

Hasil utama:

↳ Hingga 7.000× percepatan vs Jetson Nano, 300× vs RTX 4090, 100× vs H100

↳ Penggunaan energi hingga 90.000× lebih rendah dibandingkan dengan GPU

↳ Akurasi tingkat GPT-2 dicapai tanpa pelatihan ulang dari awal

↳ Perhatian jendela geser yang efisien perangkat keras yang berskala

Jika ini berskala, kita melihat dunia di mana LLM Berat tidak memerlukan pusat data hyperscaler untuk bernapas. Sebagai gantinya, mereka dapat berjalan secara lokal di perangkat edge, laptop seperti Fizz node, dan bahkan perangkat keras IoT, memberikan solusi yang cepat, murah, dan berdaya rendah.

Revolusi AI tidak hanya tentang algoritme yang lebih cerdas. Ini juga akan tentang fisika komputasi baru. Bayangkan GPT-5 berjalan offline, dengan biaya energi yang lebih murah saat ini.

2,89K

Teratas

Peringkat

Favorit