Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

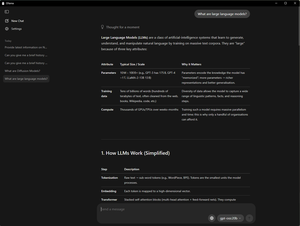

Commencez à exécuter des LLM localement avec @Ollama—expérimentez des améliorations de performance sur des PC RTX AI exécutant Gemma 3 et gpt-oss.

Glissez. Déposez. Discutez. Répétez. En savoir plus 👉

Meilleurs

Classement

Favoris