Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

è sempre bello vedere più lavoro che estende diloco e riduce i requisiti di larghezza di banda per il pre-addestramento!

22 ago, 10:13

Presentiamo SparseLoCo: un metodo efficiente nella comunicazione per il pre-addestramento di LLM.

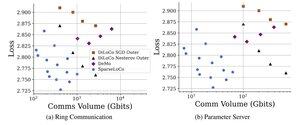

TL;DR: Sfruttiamo la sparsificazione Top-k + feedback sugli errori con i rari passi esterni di DiLoCo—comunicando solo l'1-3% dei gradienti con quantizzazione a 2 bit—superando DiLoCo e DeMo. 1/N,

ArXiv:

Github:

4,91K

Principali

Ranking

Preferiti