Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alltid hyggelig å se mer arbeid med å utvide Diloco og redusere båndbreddebehovet for fortrening!

22. aug., 10:13

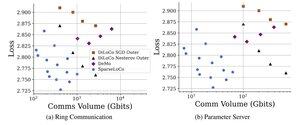

Vi introduserer SparseLoCo: en kommunikasjonseffektiv metode for LLM-fortrening.

TL; DR: Vi utnytter Top-k-sparsifisering + feiltilbakemelding med DiLoCos sjeldne ytre trinn – som bare kommuniserer 1–3 % gradienter med 2-bits kvantisering – og overgår DiLoCo og DeMo. 1/N,

ArXiv:

Github:

4,92K

Topp

Rangering

Favoritter