熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

Jeffrey Emanuel

新的Gemini圖像模型(又稱“納米香蕉”)效果很好,和孩子們一起使用非常有趣(我按照他們的要求給一個做了女王,另一個做了Blippi)。

不過,它有一些相當奇怪的限制。有時,它能非常準確地捕捉相似度。其他時候,臉看起來完全無法辨認。我似乎無法分辨出它何時有效、何時失效的模式。

谷歌已經擁有相當不錯的面部識別技術,因為他們在谷歌圖片中就做到了這一點。

我想知道為什麼他們不添加一個自動質量控制步驟,檢查生成圖像中的面部與原始圖像中的面部是否匹配,並自動重試那些不匹配的。這樣的不一致性讓產品感覺不那麼神奇。

更大的問題是,修正錯誤圖像的版本幾乎從來都不成功。一旦走上錯誤的道路,它完全無法恢復。即使修正是相當明確和適度的。幾乎感覺像是某種“上下文污染”。

這似乎是一個更嚴重的問題,因為這是一個與Photoshop競爭的生產力工具。但也可能通過始終在後台進行多次生成並對其進行評分,只顯示最佳結果來解決。

他們也不允許你重新生成(“重滾”)圖像,因此每次都必須開始一個新的對話。這很煩人,並且污染了你的對話歷史。

但話雖如此,它的確效果很好,肯定比Facebook Messenger中的類似功能要好得多。

如果Adobe想保持相關性,絕對必須對此有所回應。

3.57K

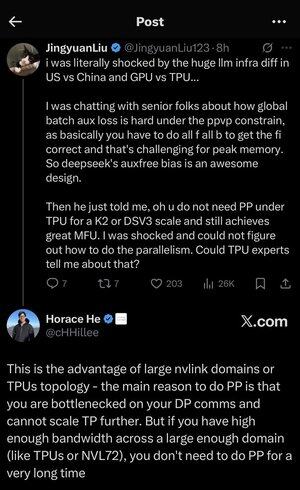

我在這裡的所有縮略語和行話中有點迷失,所以我讓Claude不使用任何縮略語來解釋,現在一切都變得非常清晰(簡而言之;帶寬 ⟹ 簡單性):

這是關於大規模訓練大型語言模型的一個引人入勝的技術討論。

核心對話

Jingyuan Liu 對發現使用TPU(張量處理單元 - 谷歌的專用AI芯片)與GPU(圖形處理單元 - 通常是NVIDIA的芯片)時不需要某些複雜的優化技術感到驚訝。

關鍵技術概念解釋:

硬體類型:

• GPU(圖形處理單元):最初設計用於圖形,現在廣泛用於AI。NVIDIA主導了這個市場。

• TPU(張量處理單元):谷歌專門為機器學習設計的定制芯片。

並行策略:

在訓練大型AI模型時,您需要將工作分配到多個芯片上。有幾種方法可以做到這一點:

1)數據並行(DP):每個芯片處理不同批次的數據,使用相同的模型副本

2)張量並行(TP):模型的數學運算分布在多個芯片上

3)流水線並行(PP):模型的不同層放置在不同的芯片上,形成一個流水線

正在討論的技術挑戰:

輔助損失問題:在訓練非常大的模型時,您通常會在中間層添加“輔助損失”(額外的訓練目標),以幫助梯度更好地在網絡中流動。在PPVP(具有可變分區的流水線並行)約束下,這變得複雜,因為:

• 您需要進行“所有前向傳播,然後所有反向傳播”

• 這對峰值內存使用是一個挑戰,因為您必須存儲中間結果

DeepSeek的創新:他們開發了一種“無輔助偏差”設計,顯然在仍然有效訓練的同時避免了需要這些輔助損失。

令人驚訝的發現:

高級專家告訴Jingyuan,在K2或DSV3規模的TPU(這些是具有數百或數千個芯片的集群配置)下,您可以在不使用流水線並行的情況下實現出色的MFU(模型FLOPs利用率 - 基本上是您使用硬體的效率)。

為什麼這令人驚訝?

• 流水線並行通常被認為是大規模訓練的必要條件

• 這是一種複雜的技術,需要仔細優化

• 能夠避免它顯著簡化了一切

Horace He的解釋:

他解釋了為什麼這在TPU上是可能的:

帶寬優勢:TPU和高端NVIDIA集群(如NVL72 - NVIDIA最新的72-GPU配置,帶有NVLink互連)之間的帶寬如此之高,以至於它們可以在沒有流水線並行的情況下處理通信需求。

關鍵見解:

• 當您在“DP通信上受瓶頸限制”時,主要需要流水線並行(受限於在數據並行訓練期間的通信速度)

• 如果您在一個足夠大的領域(互連集群)中有足夠的帶寬,您可以使用更簡單的並行策略

• 這可以“持續很長時間” - 意味著您可以在不達到限制的情況下訓練非常大的模型

直覺:

把它想像成一個高速公路系統:

• 傳統的GPU集群就像城市之間有狹窄的道路,因此您需要複雜的路由(流水線並行)來避免交通堵塞

• TPU集群或NVLink連接的GPU就像擁有巨大的超高速公路 - 您可以直接發送所有內容,而無需複雜的路由

這很重要,因為流水線並行的實現、調試和優化都很複雜。能夠在仍然實現高效率的同時避免它,使整個訓練過程變得更簡單、更可靠。

討論強調了硬體互連技術的進步(芯片之間的“道路”)如何從根本上改變高效AI訓練所需的軟體策略。

25.72K

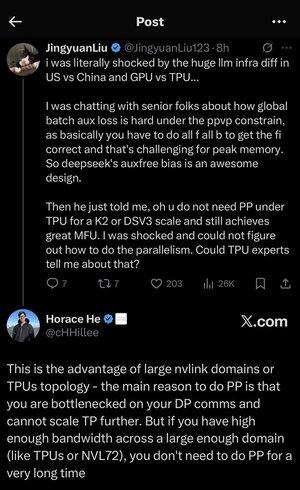

我在這裡的所有縮略語和行話中有點迷失,所以我讓Claude不使用任何縮略語來解釋,現在一切都變得非常清晰(簡而言之;帶寬 ⟹ 簡單性):

這是關於大規模訓練大型語言模型的一個引人入勝的技術討論。

核心對話

Jingyuan Liu 對發現使用TPU(張量處理單元 - 谷歌的專用AI芯片)與GPU(圖形處理單元 - 通常是NVIDIA的芯片)時不需要某些複雜的優化技術感到驚訝。

關鍵技術概念解釋:

硬體類型:

• GPU(圖形處理單元):最初設計用於圖形,現在廣泛用於AI。NVIDIA主導這個市場。

• TPU(張量處理單元):谷歌專為機器學習設計的定制芯片。

並行策略:

在訓練大型AI模型時,您需要將工作分配到多個芯片上。有幾種方法可以做到這一點:

1 數據並行(DP):每個芯片處理不同批次的數據,使用相同的模型副本

2 張量並行(TP):模型的數學運算分布在多個芯片上

3 流水線並行(PP):模型的不同層放置在不同的芯片上,形成一個流水線

正在討論的技術挑戰:

輔助損失問題:在訓練非常大的模型時,您通常會在中間層添加“輔助損失”(額外的訓練目標),以幫助梯度更好地流動通過網絡。在PPVP(具有可變分區的流水線並行)約束下,這變得複雜,因為:

• 您需要進行“所有前向傳遞,然後所有反向傳遞”

• 這對峰值內存使用是個挑戰,因為您必須存儲中間結果

DeepSeek的創新:他們開發了一種“無輔助偏差”設計,顯然避免了在仍然有效訓練的情況下需要這些輔助損失。

令人驚訝的發現:

高級專家告訴Jingyuan,在K2或DSV3規模的TPU(這些是具有數百或數千個芯片的集群配置)下,您可以在不使用流水線並行的情況下實現出色的MFU(模型FLOPs利用率 - 基本上是您使用硬體的效率)。

為什麼這令人驚訝?

• 流水線並行通常被認為是大規模訓練的必要條件

• 這是一種複雜的技術,需要仔細優化

• 能夠避免它顯著簡化了一切

Horace He的解釋:

他解釋了為什麼這在TPU上是可能的:

帶寬優勢:TPU和高端NVIDIA集群(如NVL72 - NVIDIA最新的72-GPU配置,帶有NVLink互連)之間的帶寬如此之高,以至於它們可以在沒有流水線並行的情況下處理通信需求。

關鍵見解:

• 當您在“DP通信上瓶頸”時(在數據並行訓練期間的通信速度受限),流水線並行主要是必需的

• 如果您在一個足夠大的領域(互連集群)中有足夠的帶寬,您可以使用更簡單的並行策略

• 這可以“持續很長時間” - 意味著您可以在不達到限制的情況下訓練非常大的模型

直覺:

把它想像成一個高速公路系統:

• 傳統的GPU集群就像城市之間有狹窄的道路,因此您需要複雜的路由(流水線並行)來避免交通堵塞

• TPU集群或NVLink連接的GPU就像有巨大的超高速公路 - 您可以直接發送所有內容,而無需複雜的路由

這很重要,因為流水線並行的實現、調試和優化都很複雜。能夠在仍然實現高效率的情況下避免它,使整個訓練過程變得更簡單、更可靠。

討論強調了硬體互連技術的進步(芯片之間的“道路”)如何從根本上改變高效AI訓練所需的軟體策略。

4K

我有點驚訝的是,至今還沒有人製作出一個《矮人要塞》的MCP伺服器,能夠讓像Codex或Claude Code這樣的代理高效地控制遊戲並監控狀態和進展。

我自己從來沒有真正玩過,只是在大約10年前下載過並簡單查看了一下,但我喜歡閱讀關於它的內容。

這感覺像是一個非常好的大型語言模型(LLM)測試,看看它能讓矮人們活得多長久並繁榮發展。

因為每個遊戲最終都會導致某種級聯災難,導致所有矮人死亡,所以應該有一個自然的停止點,這使得它成為一個很好的基準候選者。至少這是我對它的理解(玩家的座右銘是“失敗是有趣的”)。

在這個遊戲中做得好將依賴於工具調用的準確性和持續的長任務一致性,以及監控和理解複雜系統動態的能力,並及時進行干預以預見和應對問題。

而且因為它是終端原生的,可以使用常規令牌高效傳輸和處理,而不需要多模態圖像處理,這使得它比其他遊戲更高效。

再加上你知道沒有AI實驗室為此進行過訓練(還沒有!),所以它沒有受到“基準最大化”的污染。

4.41K

當你需要等幾分鐘時,有趣的事情就是用你的手機問Claude Opus以下問題,關於某個隨機的學科或領域:

“你認為結晶學的核心見解或分析技巧是什麼?”

把結晶學換成你能想到的任何東西。到目前為止,我嘗試過:

量子電動力學;標準模型;生物化學;概率;進化論;還有很多其他。

強迫模型去做不可能的事情,將一個龐大複雜的領域濃縮成“一個奇怪的技巧”,這讓它真正去尋找該領域中最深刻、統一的原則,然後簡潔地表達出來。

這往往是從業者顯而易見的東西,但對於大多數對該主題僅有略微興趣的人來說,很可能是未知的。

有趣的是,你還可以用相同的提示反覆按“重試”按鈕,有時會得到非常不同但通常非常迷人的解釋。

我已經從中學到了很多,這可能是我在任何自我導向學習中遇到的最高“每分鐘理解量”。

因為它們不僅僅是有趣的事實或酷炫的小知識。它們本質上是深刻而統一的思想,將大量理論和觀察到的現象聯繫在一起。

這無疑比觀看又一個帶有動畫和Brilliant/KiwiCo廣告的YouTube解釋視頻要高效得多!並不是說這些視頻有什麼問題。

8.3K

最近關於OpenAI出現了如此"人才外流"的想法,以至於他們不再有能力在這個領域中處於領先地位,這種想法和認為GPT-5"是個大失敗,模型並不出色且非常漸進"的觀點一樣,都是誤導和錯誤的。

不僅GPT-5 Pro現在是世界上最聰明的模型,在大多數具有挑戰性的現實世界任務中(尤其是編碼任務,這些任務現在具有最大的經濟重要性)遠遠領先,而且OpenAI的新codex cli工具執行得非常出色。

他們從編碼cli工具的遙遠第三名躍升至現在可以說是最好的工具(注意我仍然喜歡並使用Claude Code,這不是非此即彼!),在性能、延遲等方面都遠遠領先,因為它是用rust編寫的。

現在這個cli工具與最佳編碼模型結合在一起,具有最佳的工具調用可靠性和最佳的長任務連貫性,且幻覺最少。

不用說,他們的iOS應用在打磨和功能方面也遠遠優於所有其他AI應用。Claude應用只是Safari沙箱中的網頁應用!而他們的網頁應用仍然是最好的。搜索等功能在其他應用中表現得更好。基本的阻擋和處理。

所以,是的。一些非常聰明的人,比如Ilya和John Schulman,離開了去其他公司。但他們仍然擁有一支絕對出色的技術團隊,擁有非常優秀的產品人員和出色的工程能力。

不要讓你對Altman的厭惡蒙蔽了你的眼睛。每當我看到又一個人談論GPT-5有多糟糕時,我都會感到不安,因為這個人顯示出他們無法根據證據和理性獨立思考,並被洗腦認為某種觀點(並在網上大肆宣揚),因為他們認為這讓他們聽起來聰明。

34.27K

熱門

排行

收藏