Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alexander Long

Засновник @PluralisHQ | Доктор медичних наук

Навчання протоколу: паралельна модель з кількома учасниками, низькою пропускною здатністю

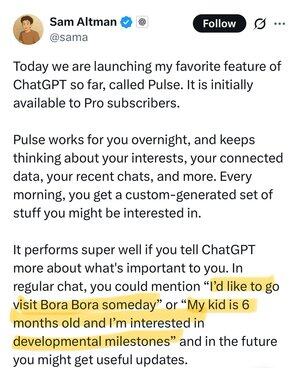

Всі готували тебе, навіть не здогадуючись, чому ти робиш те, що робиш, як тільки ця річ набирає обертів. Самий гіперперсоналізований підступний рекламний движок, який коли-небудь існував, робить RL на вас, але цільова функція - це витрачені довічні долари.

Jakob Greenfeld26 вер. 2025 р.

Ще ніколи не було так очевидно, яким буде наступний крок

Так, це реклама

212

Це якесь божевілля

Pluralis Research18 вер. 2025 р.

Результати NeurIPS опубліковані; Pluralis має три прийняті статті. По-перше, це основний результат дослідження, який в даний час лежить в основі нашого відкритого передтренувального забігу 7.5B вузла0. Два других – це також важливі результати, які ми інтегруємо в наступні забіги. Це з невеликою командою з <10 людей, які працюють під час створення node0.

1) Підпросторові мережі: масштабування децентралізованого навчання з паралелізмом комунікаційно-ефективної моделі: масштабування моделей призвело до значного прогресу в глибокому навчанні, але навчання цих моделей у децентралізованих умовах залишається складним завданням через вузькі місця в комунікації. Хоча існуючі методи стиснення ефективні при паралелі даних, вони не поширюються на паралелізм моделей. На відміну від тренування з паралельністю даних, де відбувається обмін градієнтами ваги, паралельний модель вимагає стиснення активацій і градієнтів активації, коли вони поширюються по шарах, накопичуючи помилки стиснення. Ми пропонуємо новий алгоритм стиснення, який стискає як прямі, так і зворотні проходи, забезпечуючи стиснення до 99% без погіршення конвергенції з незначними накладними витратами на пам'ять/обчислення. Використовуючи рекурсивну структуру в трансформаторних мережах, ми заздалегідь визначаємо низьковимірний підпростір, щоб обмежити активації та градієнти, що дозволяє повну реконструкцію наступних шарів. Наш метод забезпечує до 100-кратного підвищення ефективності зв'язку та дозволяє навчати моделі з мільярдними параметрами на графічних процесорах низького класу, підключених через Інтернет споживчого класу зі швидкістю до 80 Мбіт/с, відповідаючи конвергенції централізованих систем обробки даних зі з'єднаннями 100 Гбіт/с із паралельними моделями.

2) Суміші підпросторів для ефективного контекстного паралельного навчання пропускної здатності: попереднє навчання мовних моделей з розширеними контекстними вікнами підвищує їх здатність використовувати багату інформацію під час генерації. Існуючі методи розбивають вхідні послідовності на фрагменти, транслюють їх на кілька пристроїв і обчислюють увагу блок за блоком, що призводить до значних накладних витрат на зв'язок. Хоча ці методи можливі у високошвидкісних кластерах, вони непрактичні для децентралізованого навчання на з'єднаннях з низькою пропускною здатністю. Ми пропонуємо метод стиснення для ефективного паралелізму контексту в децентралізованих умовах, що забезпечує чудову швидкість стиснення понад 95% з незначними накладними витратами та без втрати конвергенції. Наша ключова ідея полягає в тому, щоб використовувати внутрішню низькорангову структуру виходів активації, динамічно обмежуючи їх вивченими сумішами підпросторів за допомогою ефективних перепараметризацій. Ми демонструємо масштабування децентралізованих моделей з мільярдами параметрів до тривалості контексту, що перевищує 100 тисяч токенів у мережах зі швидкістю до 300 Мбіт/с, що відповідає швидкості конвергенції настінного годинника централізованих моделей на міжз'єднаннях 100 Гбіт/с.

3) Неекстраговані моделі протоколів: спільне навчання та висновок без матеріалізації ваги:

Ми розглядаємо децентралізовану навчальну систему, в якій учасники спільно тренуються та обслуговують велику нейронну мережу, і де кожен учасник обробляє лише підмножину моделі. У цій схемі ми досліджуємо можливість нематеріалізованих ваг, коли повний набір ваг ніколи не доступний жодному учаснику. Ми представляємо Unextractable Protocol Models (UPM): фреймворк для навчання та висновків, який використовує налаштування сегментованої моделі для забезпечення несумісності шардів моделей (тобто підмножин), що зберігаються учасниками, на різних етапах часу. UPM періодично вводять змінні в часі, випадкові, обернені перетворення на кордонах учасників; зберігаючи загальну функцію мережі, але роблячи крос-часові збірки незв'язними. На Qwen-2.5-0.5B і Llama-3.2-1B 10 000 перетворень залишають незмінною розгубленість FP 32 (дрейф PPL Дженсена-Шеннона). Застосування перетворення кожні 30 секунд додає 3% затримки, 0,1% пропускної здатності та 10% накладних витрат на GPU-пам'ять при висновках, тоді як накладні витрати на тренування зменшуються до 1,6% часу та < 1% пам'яті. Ми розглянемо кілька атак, які показують, що вимоги прямих атак непрактичні і від них легко захиститися, і що тонке налаштування зшитих перегородок на основі градієнта споживає токени, необхідні для тренування з нуля. Дозволяючи моделям спільно навчатися, але не витягувати, UPM роблять практичним вбудовування програмних механізмів стимулювання в децентралізоване навчання, кероване спільнотою.

15,42K

Найкращі

Рейтинг

Вибране