Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

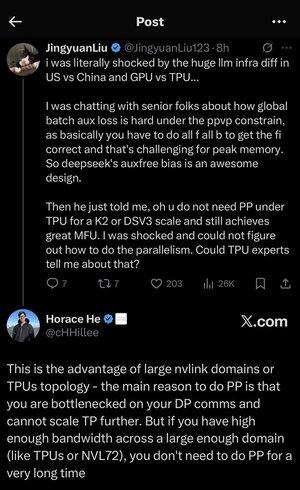

M-am pierdut puțin în toate acronimele și jargonul de aici, așa că l-am pus pe Claude să explice fără a folosi acronime și acum totul are sens (tldr; lățime de bandă ⟹ simplitate):

Aceasta este o discuție tehnică fascinantă despre antrenarea modelelor lingvistice mari la scară.

Conversația de bază

Jingyuan Liu își exprimă surprinderea când descoperă că nu aveți nevoie de anumite tehnici complexe de optimizare atunci când utilizați TPU-uri (Tensor Processing Units - cipurile AI specializate de Google) versus GPU-uri (Graphics Processing Units - de obicei cipurile NVIDIA).

Concepte tehnice cheie explicate:

Tipuri hardware:

• GPU (Graphics Processing Unit): Proiectat inițial pentru grafică, acum utilizat intens pentru AI. NVIDIA domină această piață.

• TPU (Tensor Processing Unit): cipurile personalizate de la Google special pentru învățarea automată.

Strategii de paralelism:

Când antrenați modele masive de inteligență artificială, trebuie să împărțiți munca între mai multe cipuri. Există mai multe moduri de a face acest lucru:

1Paralelism de date (DP): Fiecare cip procesează loturi diferite de date cu aceeași copie a modelului

2Paralelismul tensorial (TP): Operațiile matematice ale modelului sunt împărțite între cipuri

3Paralelismul conductei (PP): Diferite straturi ale modelului sunt plasate pe cipuri diferite, creând o conductă

Provocarea tehnică discutată:

Problema pierderilor auxiliare: Când antrenați modele foarte mari, adăugați adesea "pierderi auxiliare" (obiective de antrenament suplimentare) la straturile intermediare pentru a ajuta gradientele să curgă mai bine prin rețea. În cadrul constrângerilor PPVP (Pipeline Parallelism with Variable Partitioning), acest lucru devine complex deoarece:

...

Limită superioară

Clasament

Favorite