Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeremy Howard

Jeremy Howard lagt ut på nytt

Kimis grunnlegger, Zhilin Yangs intervju er ute.

Igjen, du kan la Kimi oversette for deg: ) masse innsikt der.

Flere opptak:

1/ Basismodellfokus: K2 har som mål å være en solid basismodell. Vi har funnet ut at dataveksten av høy kvalitet er langsom, og multimodale data øker ikke tekstens «IQ» nevneverdig. Så vi fokuserer på å maksimere verdien av hvert datatoken – tokeneffektivitet.

2/ Dataomformulering: Med 30T-tokens er bare en liten del data av høy kvalitet (milliarder av tokens). Vi omformulerer disse for å gjøre dem mer effektive for modellen, og forbedrer generaliseringen.

3/ Agentisk evne: Vi tar sikte på å forbedre generaliseringen. Den største utfordringen er å få modellen til å generalisere langt utover spesifikke oppgaver. RL forbedrer dette i forhold til overvåket finjustering (SFT).

4/ AI-Native Training: Vi utforsker flere AI-native måter å trene modeller på. Hvis AI kan gjøre god justeringsforskning, vil den generalisere bedre, utover optimalisering av enkeltoppgaver.

5/ RL vs SFT: RLs generalisering er bedre, ettersom den lærer av eksempler på retningslinjer, men den har sine begrensninger. RL bidrar til å forbedre spesifikke oppgaver, men det er vanskelig å generalisere til alle scenarioer uten skreddersydde oppgaver.

6/ Lange kontekster: Kontekstens lengde er avgjørende, vi trenger millioner. Utfordringen er å balansere modellstørrelse og kontekstlengde for optimal ytelse, ettersom noen arkitekturer forbedres med lang kontekst, men forverres med korte.

72,97K

Cortes' doktorgradstittel btw var: "Prediksjon av generaliseringsevne i læringsmaskiner".

jack morris26. aug., 20:11

først trodde jeg skaleringslover oppsto i OpenAI (2020)

så trodde jeg de kom fra Baidu (2017)

Nå er jeg opplyst:

Skaleringslover ble først utforsket ved Bell Labs (1993)

19,04K

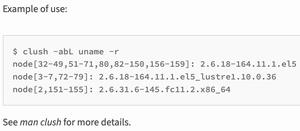

For folk som ønsker å administrere noen få bokser uten å øke kompleksiteten, bør du vurdere å bruke et cluster ssh-verktøy som ClusterShell eller Fabric.

Den sender bare ssh-kommandoer til grupper av bokser parallelt og viser deg det konsoliderte resultatet.

F.eks.

@levelsio23. aug., 06:57

Hvilken app skal jeg bruke for å administrere alle mine små Hetzner VPS-er?

I dag begynte jeg å flytte over mitt første virkelige produksjonssted Remote OK fra min nåværende 12 år gamle VPS (med alle nettstedene mine på den som Photo AI, Nomad List etc) til en ny Hetzner VPS

Hvert nettsted på sin egen lille VPS er min plan

Men jeg vil ha noe for å klare det hele, som å sjekke serverbelastningen, diskbruken, se Ubuntu-versjonen osv

Cockpit?

25,31K

IIUC, noen fikk nettopp entropix til å fungere og publiserte det...

Jiawei Zhao23. aug., 04:00

Vi introduserer DeepConf: Tenk dypt med selvtillit

🚀 Første metode for å oppnå 99.9 % på AIME 2025 med åpen kildekode-modeller! Ved å bruke GPT-OSS-120B selv uten verktøy, nådde vi denne nesten perfekte nøyaktigheten samtidig som vi sparte opptil 85 % genererte tokens.

Det gir også mange sterke fordeler for parallell tenkning:

🔥 Ytelsesøkning: ~10 % nøyaktighet på tvers av modeller og datasett

⚡ Ultraeffektiv: Opptil 85 % færre tokens generert

🔧 Plug & play: Fungerer med ALLE eksisterende modeller - null trening nødvendig (ingen hyperparameterjustering også!)

⭐ Enkel å distribuere: Bare ~50 linjer med kode i vLLM (se PR nedenfor)

📚 Papir:

🌐 Prosjekt:

Felles arbeid med: @FuYichao123, xuewei_wang, @tydsh

(se detaljer i kommentarene nedenfor)

77,33K

Jeremy Howard lagt ut på nytt

AI demonstrerer sunk-cost-feilslutningen perfekt: Bare en "dette fungerer ikke!" melding, tenker du, og det vil fikse det!! Men ofte vil det ikke gjøre det, og nå har du kastet bort 30 minutter på å tigge om at du kunne ha brukt på å lære hvordan du faktisk gjør det selv.

342,26K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til