Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

REI Network

Promover la IA a través de principios científicos fundamentales • Investigación liderada por @0xreisearch sobre @Base y @HyperliquidX

Menos de dos meses desde que comenzó la beta expandida, miles de consultas son procesadas diariamente por Rei. Destacamos algunas características y capacidades populares con las que los testers han estado experimentando.

→ Analizar y visualizar flujos de billetera inteligente, transacciones y sentimiento

→ Prever eventos macroeconómicos, mercados y tendencias

→ Explorar los últimos trabajos de investigación tecnológica y académica

Próximamente en la App Store y @baseapp

35.57K

Menos de dos meses desde que comenzó la beta expandida, miles de consultas son procesadas diariamente por Rei. Destacamos algunas características y capacidades populares con las que los testers han estado experimentando:

→ Analizar y visualizar flujos de billetera inteligente, transacciones y sentimiento

→ Prever eventos macroeconómicos, mercados y tendencias

→ Explorar los últimos documentos de investigación tecnológica y académica

Próximamente en la App Store y @baseapp

83

Notas de la versión Core 0.3.2

Novedades

Core ahora entiende mejor las solicitudes complejas al descomponerlas en sus partes componentes. Cuando pides algo que involucra múltiples pasos o requisitos, las unidades identificarán y abordarán automáticamente cada aspecto de manera mucho más efectiva, reduciendo la necesidad de aclaraciones posteriores.

Características principales

• Motor de descomposición de intenciones mejorado: Análisis y descomposición mejorados de solicitudes complejas de los usuarios en componentes accionables

• Análisis de solicitudes avanzado: Mejor comprensión de requisitos implícitos y solicitudes de múltiples capas

Mejoras

• Comprensión contextual: Mejor reconocimiento de las necesidades matizadas de los usuarios dentro de solicitudes individuales

• Procesamiento de múltiples aspectos: Identificación automática cuando las solicitudes requieren múltiples tipos de respuestas (contenido + formato + análisis)

• Precisión en el primer intento: Reducción de intercambios necesarios para cumplir con la intención del usuario

Corrección de errores

• Se corrigieron fallos en el análisis de intenciones que causaban salidas incompletas

• Se resolvieron casos donde se pasaron por alto o se ignoraron requisitos implícitos

• Se corrigieron vacíos en las respuestas cuando los usuarios solicitaban múltiples acciones simultáneas

Mejoras en la experiencia del usuario

• Flujo de interacción optimizado que reduce la necesidad de solicitudes de aclaración

• Generación de respuestas más intuitiva que anticipa las necesidades del usuario

• Sensación de colaboración mejorada: menos solicitudes, más asistencia natural

Estado: En vivo, se esperan múltiples mantenimientos cortos para ajustar la producción a esta nueva actualización en las próximas 48 horas.

11.68K

Se acaba de lanzar la versión beta del motor de datos de cadena

Versión beta: Ahora en producción. Estamos impulsando esta iteración para recopilar comentarios y patrones de uso.

Este motor es una actualización importante de las capacidades de procesamiento de datos de la unidad. El enfoque toma elementos seleccionados de los fundamentos de MCP, pero representa una metodología fundamentalmente diferente diseñada para abordar problemas de confiabilidad al manejar grandes fragmentos de datos.

La canalización de ingesta mejorada ahora captura datos en cadena con una precisión significativamente mayor, lo que permite a las unidades ofrecer información analítica más profunda en todas las métricas.

Mejoras clave:

• Precisión de captura de datos mejorada para todas las unidades con mayor confiabilidad

• Profundidad analítica mejorada y capacidades de generación de información

• Mejor reconocimiento de patrones en todos los conjuntos de datos

• Capacidades de informes de unidades más completas

• Mayor precisión en la interpretación de datos y generación de gráficos

• Integración de nuevos @nansen_ai que proporciona una visión más profunda de la actividad en cadena

Las unidades ahora ofrecen análisis sustancialmente más detallados con mayor precisión y una comprensión más profunda del mercado.

Estado: En vivo en producción (Beta) - ¡Necesitamos sus pruebas!

Fuentes de datos: @coingecko @elfa_ai @nansen_ai @birdeye_so @dexscreener @DefiLlama

-----

Lanzamiento del nuevo logotipo

Nuestro nuevo logotipo ya está disponible. Encarna las capas multimodales y paralelas de Core, el concepto fundamental que dio origen a nuestro primer prototipo, @unit00x0, en 2024.

21.71K

Notas de la versión Core 0.3.1

Memoria conductual: directivas básicas autoadaptables

Novedades

Un nuevo tipo de memoria llamado "memoria de comportamiento" que adapta explícitamente el comportamiento de la unidad en función de las solicitudes del usuario mientras mantiene intactos todos los conceptos aprendidos. Inspirado en la memoria genética en humanos, este enfoque permite la adaptación dinámica del comportamiento a través de directivas centrales automodificables. La memoria genética estará en el centro de un número significativo de actualizaciones importantes de Core.

Cambios clave

• Adaptación explícita: Lo que estaba implícito ahora es extremadamente explícito

• Activación selectiva: se activa solo cuando el razonamiento lo requiere

• Conocimiento preservado: Toda la memoria conceptual permanece inalterada

• Directivas básicas dinámicas: funciona como instrucciones autoadaptables integradas en lo profundo de cada unidad

Cómo funciona

La memoria conductual actúa como una capa entre el conocimiento y el comportamiento:

• Analiza sus solicitudes

• Se activa cuando es necesario

• Adapta las directivas básicas en tiempo real

• Preserva todos los conceptos aprendidos

Ejemplos en la práctica

Las adaptaciones conductuales pueden ocurrir de dos maneras:

1. Solicitudes explícitas: Solicite directamente comportamientos específicos

2. Aprendizaje implícito: las unidades infieren preferencias a partir de sus patrones de conversación

• Preferencias de notación: Pídale a una unidad que use "B" para miles de millones en lugar de deletrearla

• Estilo de comunicación: Solicite un lenguaje formal para los informes o un tono informal para la lluvia de ideas

• Formato de salida: Haga que las unidades siempre presenten datos en tablas en lugar de párrafos

• Profundidad técnica: Ajuste de resúmenes de alto nivel a explicaciones técnicas detalladas

• Estructura de respuesta: cambia entre viñetas, listas numeradas o prosa fluida

• Lenguaje de dominio: use terminología específica de la industria (por ejemplo, "confirmaciones" frente a "actualizaciones" para desarrolladores)

Las unidades se adaptan continuamente en función de sus interacciones, refinando su comportamiento con el tiempo. Cada adaptación persiste hasta que solicite un cambio o restablezca los comportamientos por completo.

Impacto

Las unidades ahora ajustan explícitamente su comportamiento para que coincida con sus necesidades sin olvidar lo que han aprendido. Piense en ello como directivas centrales dinámicas que se activan según el contexto, similar a cómo la memoria genética proporciona respuestas adaptativas heredadas en los sistemas biológicos.

Los usuarios pueden restablecer la memoria de comportamiento en cualquier momento simplemente pidiendo a las unidades que restablezcan sus comportamientos.

Migración

Automático. No se requiere ninguna acción.

9.84K

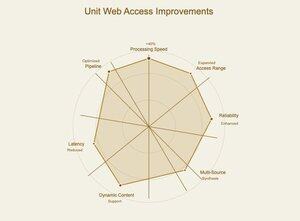

Actualización de la navegación web: Las unidades ahora pueden acceder a los datos web de manera significativamente más rápida y confiable.

Lo que cambió:

• Aumento de la velocidad de procesamiento de datos web en un 40%

• Acceso más amplio a sitios y tipos de contenido previamente difíciles de alcanzar

• Recuperación de datos más consistente en diferentes estructuras del sitio web

Impacto práctico: Las unidades ahora pueden manejar solicitudes de investigación en tiempo real que antes eran demasiado lentas o poco confiables.

¿Necesita datos actuales del mercado, análisis de noticias en vivo o verificación de datos de múltiples fuentes? Las unidades ahora pueden extraer de docenas de fuentes en segundos en lugar de minutos.

Las aplicaciones web más complejas, el contenido dinámico y las arquitecturas de sitios modernas que solían causar errores ahora funcionan a la perfección. Esto significa mejores respuestas cuando se pide a las unidades que analicen los eventos actuales, comparen productos de varios minoristas o investiguen temas que cambian rápidamente.

8.2K

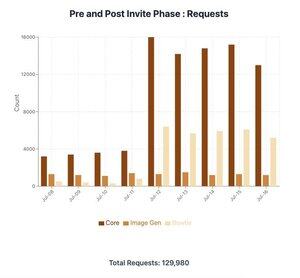

3 días desde los códigos de invitación:

• 3 veces las solicitudes diarias a Core

• 5 veces más solicitudes diarias a Bowtie, ya que la versión 0.3 introduce el aprendizaje profundo

• La generación de imágenes está limitada para la asignación de GPU

Esta fase marca un paso significativo hacia la beta abierta a medida que recopilamos comentarios, estudiamos el comportamiento de uso y escalamos la infraestructura.

4.74K

1/4

¿Qué es Core? Entendiendo nuestro propio enfoque de una arquitectura de cerebro sintético

Core no es un LLM: Core no es un LLM ajustado, no es un nuevo LLM y no es un LLM en absoluto. En cambio, Core es un cerebro sintético multimodal, un tipo fundamentalmente diferente de arquitectura de IA.

Terminología clave para entender el núcleo:

1. Cerebro sintético: Core es un sistema cognitivo unificado en el que múltiples modelos y algoritmos de IA funcionan como componentes neuronales interconectados dentro de una única arquitectura. Piense en ello como un cerebro digital con regiones especializadas, no como una colección de herramientas.

2. La arquitectura Bowtie: El sustrato de memoria del núcleo que almacena información como vectores semánticos Y nodos de conceptos abstractos, crea conexiones entre conceptos aparentemente no relacionados y permite la formación genuina de conceptos, no solo la coincidencia de patrones.

3. Grupo de razonamiento: La parte cognitiva del núcleo que orquesta todos los procesos de pensamiento, tomando decisiones sobre qué vías neuronales activar para una tarea determinada, el grupo de razonamiento es profundamente multimodal y funciona a través de sesgos de procesamiento y sofisticación paralelos.

504

Populares

Ranking

Favoritas

Onchain en tendencia

Tendencia en X

Principales fondos recientes

Más destacadas